Insight #115_OpenAI 기업구조 변경, 제미나이 3, 강화학습과 지속학습, AI 버블론, 커서, Periodic Labs, TPU v7, 스케일업 네트워크, 네비우스 경제성 백서, 로봇 손, Tempo, Benchmark, 헨리 크라비스, 슈워츠만, 일리야의 Taste & Beauty

11월 뉴스레터 발행을 건너뛰어서 10월 중순부터의 이야기를 다루었는데, 불과 두달 사이에도 AI 산업에는 참 다양한 소식들이 많았다는걸 다시끔 느낄 수 있었습니다. 정말 세상이 역동적으로 변화하는게 느껴지네요.

이번 뉴스레터가 아마도 올해 마지막 뉴스레터가 될 것 같은데, 모두들 일년 동안 정말 감사했습니다. 내년에도 계속해서 같이 세상의 변화를 따라가보시죠 :)

오늘은 AI, 반도체, 인프라, 하드웨어, 핀테크, 금융, 투자, 비즈니스에 대해 다룹니다.

뉴스레터 외에도 텔레그램 및 블로그에서 저의 생각을 접해보실 수 있습니다.

#AI

The next chapter of the Microsoft–OpenAI partnership

OpenAI가 자본 재구조화(recapitalization)를 완료하며 기업 구조를 단순화하는데 성공했다.

마이크로소프트 입장에서는 지분과 매출 쉐어링, 모델 접근권 등을 얻었기 때문에 손해볼꺼 없는 딜을 한 것 같고, OpenAI 입장에서는 마이크로소프트의 컨트롤에서 벗어나 독립적인 주체가 되었다는 것만 해도 얻어낸게 충분하다고 본다.

개인적으로는 당장은 마이크로소프트가 예상보다 더 큰걸 얻어낸 것 같은데, 장기적인 뷰로 보면 어떻게 될지 모르겠다 (구글이 제미나이를 가지고 있는데, 마소는 자체 모델이 없는 상황이 될 수 있으니...)

아무튼, 이제부터 샘 알트만은 진짜 하고 싶은 대로 하겠군!

“Microsoft는 OpenAI 이사회가 공익법인(Public Benefit Corporation, PBC)을 설립하고 자본 재구조화를 진행하는 것을 지지합니다. 이 재구조화 이후 Microsoft는 OpenAI Group PBC의 지분 약 1,350억 달러 규모(약 27%)를 보유하게 됩니다.”

“OpenAI는 계속해서 Microsoft의 프론티어 모델(frontier model) 파트너로 남으며, Microsoft는 독점적 지식재산(IP) 권리 및 Azure API 독점권을 인공일반지능(AGI) 이 등장하기 전까지 유지합니다.”

“OpenAI가 AGI 도달을 선언하면, 독립적인 전문가 패널이 이를 검증하게 됩니다. Microsoft의 모델 및 제품 관련 IP 권리는 2032년까지 연장되며, AGI 이후의 모델까지 포함합니다.”

“OpenAI는 일부 제품을 제3자와 공동 개발할 수 있습니다. 단, API 기반 제품은 여전히 Azure 독점이며, 비-API 제품은 어떤 클라우드에서도 서비스할 수 있습니다.”

“OpenAI는 추가로 2,500억 달러 규모의 Azure 서비스를 구매하기로 계약했습니다. 이에 따라 Microsoft는 더 이상 OpenAI의 컴퓨트 제공권에 대한 우선 협상권을 갖지 않습니다.”

Sam, Jakub, and Wojciech on the future of OpenAI with audience Q&A

내년까지 AI 성능을 연구 인턴 수준으로 끌어올리겠다는 샘 알트만. 그리고 상장 가능성에 대해서도 열어놓은 것도 인상적.

“우리는 내년 9월까지 상당한 양의 컴퓨트를 투입해 연구자들을 의미 있게 가속할 수 있는 매우 유능한 AI 연구 인턴에 도달하겠다는 계획을 세우고 있습니다. 정말로 가까운 시점이라고 믿습니다. 그리고 우리는 2028년 3월까지 더 큰 연구 프로젝트를 자율적으로 수행할 수 있는 시스템, 즉 의미 있는, 완전 자동화된 AI 연구자에 도달하기를 바라보고 있습니다.”

“(AGI는 언제 일어날까요?) 오늘 우리가 밝히려 했던 것 중 하나는, “2028년 3월까지 진정한 자동화된 AI 연구자를 갖는 것이 우리의 의도와 목표이며, 그것이 의미하는 바를 정의하겠다”는 것이, 모든 사람을 만족시킬 AGI 정의를 찾으려 하는 것보다 훨씬 유용하다는 점입니다.”

“또 한 가지 언급하자면, 우리는 매우 복잡한 기술로 작업하고 있으며, 이 모든 알고리즘을 이해하려 하고 있습니다. 초기에는 우리가 상상하기를, AGI는 모든 답을 알아낸 순간—최종적인 무언가—라고 여겼습니다. 하지만 이제 우리는 점점, 지능 곡선(아마도 다차원)이 있고, 인간은 그 어딘가에 있으며, 딥러닝을 스케일하고 새로운 알고리즘을 개발하는 과정에서, 결국 우리는 그 지점에 점점 다가가고, 결국—이미 여러 축에서—그 지점을 넘어서게 될 것임을 깨닫고 있습니다. 그리고 그것이 곧 모든 문제를 해결했다는 뜻은 아니라는 점—우리가 진지하게 생각해야 하는 부분—을 함께 이해하고 있습니다.”

“(IPO는 여전히 계획되어 있나요?) 구체적 계획은 없지만, 우리의 자본 필요와 회사의 규모를 감안하면 가장 가능성이 큰 경로라고 말할 수 있습니다. 하지만 지금 우리에게 최우선은 아닙니다.”

How OpenAI Shapes Its Research And What’s Next - EP 46 Mark Chen

OpenAI의 최고 연구 책임자(Chief Research Officer) 마크 첸(Mark Chen) 인터뷰인데, 현재 OpenAI 우선순위가 어디에 있는지 보인다.

특히 내부적으로 인턴 수준의 AI 과학 연구자를 구현해내고 있다는 부분이 눈에 들어온다. 샘 알트만이 얼마전 강조한 부분이기도 해서.

“야쿱과 저는 1~2달마다 OpenAI의 모든 프로젝트를 점검하는 작업을 합니다. 약 300개의 프로젝트가 담긴 거대한 스프레드시트가 있는데, 우리는 각각을 최대한 깊이 이해하고 순위를 매기려고 노력합니다. 500명 규모의 회사에서는 핵심 우선순위가 무엇인지 이해하는 게 중요하고, 그게 구두로든 컴퓨팅 자원 할당 방식을 통해서든 명확하게 전달되어야 합니다.”

“OpenAI가 다른 거대 연구소들과 차별화되는 점 중 하나는 항상 핵심 탐구 연구(exploratory research)를 중심에 둔다는 겁니다. 우리는 다른 연구소의 결과를 복제하거나 벤치마크 점수를 따라잡는 사업을 하지 않습니다. 그건 우리의 주된 업무가 아닙니다. 우리는 항상 다음 패러다임이 무엇인지 알아내려고 노력하며, 그것을 제대로 찾기 위해 자원을 투자할 의향이 있습니다. 아마 대부분 놀라시겠지만, 실제 결과물(모델)을 훈련하는 것보다 탐구 연구에 더 많은 컴퓨팅 자원이 들어갑니다.”

“(AI 발전이 몇몇 천재들에게 달려 있는 건가요? 일리야, 노암(Noam), 알렉(Alec) 같은 사람들이 떠나면 어떻게 되나요?) 저는 그게 좋은 연구를 하는 유일한 방법이라는 데 동의하지 않습니다. OpenAI는 상향식(bottom-up) 문화가 강해서, 최고의 아이디어는 놀라운 곳에서 유기적으로 나옵니다. 우리는 스타를 만들어낼 능력에 자신이 있습니다. 물론 외부에도 훌륭한 인재들이 있지만, 우리는 최고의 팀을 꾸리기 위해 노력할 뿐입니다.”

“재밌는 건, 요즘 모델들이 대회 문제를 꽤 잘 풉니다. 우리가 생각하는 방식과는 달라요. 우리는 패턴 인식으로 풀지만, 모델들은 아주 특이한(ad hoc) 문제들도 잘 풉니다. 이전에 제가 모델이 못 풀 거라고 생각했던 문제들이 오히려 AI에게는 쉬운 문제였습니다. 이걸 보면서 프론티어 연구에서 인간과 AI가 함께하면 놀라운 일을 해낼 거라는 느낌을 받았습니다. AI는 무엇이 쉽고 어려운지에 대해 다른 직관을 가지고 있으니까요.”

“지난 2년은 추론(Reasoning)에 엄청난 자원을 쏟아부었고 성공했습니다. 그 부작용으로 사전 학습이나 사후 학습 근육이 좀 빠졌죠. 지난 6개월간 야쿱과 저는 그 근육을 다시 키우는 데 집중했습니다. 사전 학습은 죽지 않았습니다. 스케일링도 죽지 않았고요. 우리는 사전 학습에 여전히 많은 여지가 있다고 생각합니다. 최근의 노력 덕분에 훨씬 더 강력한 모델을 훈련하고 있고, 제미나이 3와 경쟁하는 데 큰 자신감을 줍니다.”

“(컴퓨팅 자원에 대한 수요는 여전한가요?) 네, 3배, 10배가 있어도 바로 효과적으로 쓸 수 있습니다. 스케일링을 멈출 생각은 전혀 없습니다. 제미나이 3는 데이터 효율성 면에서 아직 해결 못 한 부분이 있어 보입니다.”

“1년 안에 연구 방식을 바꾸고 AI 인턴을 활용하게 될 겁니다. 2년 반 안에는 AI가 엔드 투 엔드(end-to-end) 연구를 수행하게 하고 싶습니다. 아이디어만 내면 모델이 구현하고 디버깅하는 세상이 올 겁니다.”

“OpenAI는 연구 중심 회사입니다. 순수 AI 베팅이죠. AGI를 구축하는 게 핵심 목표이고 제품은 거기서 자연스럽게 흘러나옵니다. 우리는 AI 연구를 자동화하고, 과학적 발견을 자동화하고, 경제적으로 유용한 노동을 자동화하고 싶습니다. 지난 1년의 가장 큰 업데이트는 과학 연구 자동화가 실제로 일어나고 있다는 겁니다.“

OpenAI가 엔터프라이즈 AI 현황 보고서를 공개했는데, 아무래도 (소비자 영역이 아닌) 엔터프라이즈 영역에서는 OpenAI가 압도적 우위를 보이고 있지는 못하기 때문에 이리저리 고민이 많을 것 같다. 그러니까 이런 리포트도 공개하는 것이겠지…?

“메시지 증가: 지난 1년간 챗GPT 엔터프라이즈의 주간 메시지는 약 8배 증가했고, 평균 근로자의 메시지 전송량은 30% 늘어났습니다.”

“구조화된 도구 사용 급증: ‘Custom GPTs’와 ‘Projects’의 주간 사용자는 연초 대비 19배 증가했습니다. 현재 전체 엔터프라이즈 메시지의 약 20%가 이러한 구조화된 도구를 통해 처리되고 있습니다.”

“추론 능력 활용: 조직당 평균 추론(reasoning) 토큰 소비량이 지난 12개월 동안 320배 증가했습니다. 이는 기업들이 단순 질의를 넘어 더 복잡하고 지능적인 모델을 시스템에 통합하고 있음을 시사합니다.”

“규모 확대: 9,000개 이상의 조직이 100억 개 이상의 토큰을 처리했으며, 약 200개 조직은 1조 개 이상의 토큰을 사용했습니다.”

“코덱스(Codex)의 부상: AI 기반 개발 도구인 Codex의 주간 활성 사용자는 최근 6주간 2배 증가했으며, 주간 메시지는 50% 증가했습니다.”

ChatGPT Group Chats, Meta and the Encryption Trade-off, Network Effects and Ad Models - Stratechery

(아마도) ChatGPT가 그룹채팅을 통해 얻고자 하는 것: 무료 이용자를 활용한 네트워크 효과의 발생.

당장은 성공 가능성을 잘 모르지만, 만약에 그룹채팅이 보편화되면 (구글 보다는) 메타가 속이 쓰릴 것 같네.

“만약 Gemini 3가 경쟁사를 압도해 버린다면, OpenAI는 끝장나는 걸까요? 제 생각은 “그렇지 않다”입니다. OpenAI는 이미 수억 명의 사람들의 삶 속에 깊이 자리 잡았고, 이 습관은 쉽게 바뀌지 않습니다. 그리고 결정적으로, 이 ‘습관의 우위’를 네트워크 효과의 우위로 확장하는 일은 ChatGPT에 큰 도움이 될 것입니다.”

“그렇기 때문에, 이번 그룹 채팅 기능이 Sora와 달리 ChatGPT 앱 안에 들어간다는 점이 의미 있다고 생각합니다. 개인적으로도 이게 더 자연스러운 위치라고 봅니다. 그룹 채팅은 또 다른 방식의 “AI 사용”이고, 대부분의 사람들에게 “AI 사용”은 곧 ChatGPT를 의미하기 때문입니다. 하지만 동시에, 여기에 분명한 전략적 의도도 존재합니다.”

“또한, 그룹 채팅을 유료 사용자에게만 제공하는 대신, 모든 사람에게 제공하는 것도 네트워크 효과를 노리기에 좋은 이유입니다. 그룹 채팅을 시작하려고 할 때 상대가 유료 회원인지 무료 회원인지부터 따져봐야 할 이유는 전혀 없습니다. 네트워크 효과를 목표로 한다면 마켓을 일부러 좁혀서는 안 되죠.”

A new era of intelligence with Gemini 3

구글이 제미나이 3.0을 공개했고, 결과적으로 OpenAI에게 정말 강력한 펀치를 날린 것 같다.

개인적으로 리서치나 팩트 확인 같은 작업들은 여전히 ChatGPT를 이용하지만, 나머지 일상적인 대화나 검색 같은건 제미나이를 이용하고 있다. 전체적으로 답변이 부드러우면서도 속도까지 빠르다보니 제미나이가 좋게 느껴진다.

제미나이 3는 여전히 스케일링의 법칙이 유효하다는 것과, TPU의 잠재력을 세상에 인식시키는 계기가 되었다.

Oriol Vinyals (구글 딥마인드 소속 Gemini 팀 co-리더)

Gemini 3 성능의 비밀은 간단 : 사전훈련과 사후훈련 개선

사전 훈련 : 스케일링은 끝났다는 일반적인 믿음과는 달리, 연구팀은 엄청난 도약을 달성했음. 2.5와 3.0 사이의 차이는 우리가 본 것 중 가장 큼. 벽이 보이지 않음

사후 훈련 : 알고리즘 발전과 개선의 여지가 많은, 아직 완전히 새로운 분야

Demis Hassabis & Josh Woodward Tell Us Why Gemini 3.0 Puts Google in Front of the A.I. Race

하사비스 왈:

“(지난 5월에 AGI까지 5~10년 남았다고 하셨는데 여전히 같은 타임라인인지?) 궤도에 정확히 올라와(dead on track) 있다고 봅니다. 무슨 뜻인지 아시겠죠? 우리는 이 진척 상황에 정말 만족합니다. 정말 놀라운 모델이라고 생각하고, 제가 예상했던 것과 제미나이 시작 이후 지난 2년여간 우리가 밟아온 궤적에 딱 맞습니다.”

“하지만 일반 지능에서 기대할 수 있는 전반적인 일관성을 확보하기 위해서는 여전히 한두 가지가 더 필요하다고 생각합니다. 기억력(memory)과 추론(reasoning)에 대한 개선도 여전히 필요하고, 아마 여러분도 아시다시피 우리가 시머(Simmer)나 지니(Genie)로 작업하고 있는 ‘월드 모델(world model)’ 아이디어 같은 것들도요.”

“(새로운 프론티어 모델이 나올 때마다 스케일링 법칙(scaling laws)에 대한 논의, 그리고 수확 체감(diminishing returns)이 나타나기 시작했는지에 대한 논의를 다시 하게 되는 것 같습니다. 어떻게 생각하시나요?) 사람들은 ‘수확 체감’이라는 말을 들으면 “0이냐 아니면 지수함수적이냐(exponential)”라고 생각하죠. 하지만 그 중간도 있습니다. 체감할 수는 있습니다. 매 시대마다 기하급수적으로 두 배가 되는 건 아닐지라도, 여전히 충분히 할 가치가 있고, 투자 수익률이 매우 높을 수 있습니다. 저는 우리가 그 시대에 있다고 생각합니다.”

AI, networks and Mechanical Turks — Benedict Evans

AI 시대에 구글이 유의미한 승자로 남는다면 비즈니스 역사에 아주 유의미한 케이스가 될 것 같다.

“아마존은 10억 개에 가까운 SKU(상품 품목)를 보유하고 있지만, 그 상품들에 대해 아는 것이라고는 인간이 입력한 메타데이터와 어느 정도 수준의 구매 상관관계뿐입니다. 인스타그램이나 틱톡도 같은 문제를 안고 있습니다. 이 시스템들은 SKU 간의 상관관계나 Funnel 아래 단계의 데이터는 가지고 있지만 ‘이유’는 모릅니다. 마치 개가 열쇠 소리를 들으면 산책을 나간다는 높은 상관관계는 알지만, 정작 열쇠가 무엇인지는 모르는 것과 같습니다.”

“그러나 LLM은 최소한 ‘무엇’과 ‘왜’에 대한 자동화된 이해에 있어 단계적인 도약을 보여줍니다. 모델은 텍스트, 이미지, 비디오, 제품 및 모든 메타데이터를 살펴보고, 이를 어떤 종류의 ‘이해’—혹은 적어도 훨씬 더 광범위한 종류의 상관관계—를 갖춘 패턴으로 연결할 수 있습니다.

“인터넷은 과거의 모든 필터, 큐레이션, 편집 과정을 없애버렸고, 그 결과 우리는 사실상 무한한 상품, 무한한 미디어, 무한한 소매점에 노출되었으며, 우리가 모르는 것을 찾거나 볼 방법이 사라졌습니다. 인터넷이 제공했던 필터들은 매우 불완전했습니다. 하지만 이제 우리는 근본적으로 새롭고 다른 종류의 필터를 갖게 되었습니다. 이것은 단순히 구글을 대체하는 것보다 훨씬 더 큰 문제(질문)인 것 같습니다.”

Inside Google’s Two-Year Frenzy to Catch Up With OpenAI - Wired

구글의 화려한 부활(?) 기념으로 다시 읽었는데, 역시나 다시 읽어도 재밌네. 어떤 사람이 어떤 변화를 주도하느냐를 잘 관찰하면 기업의 변화를 미리 예상해볼 수 있는 것 같다.

이런거 보면 회사는 정말 살아 움직이는 유기체 같다. 고통을 받으니 각성해버리잖아.

“당시 구글은 세계적 수준의 두 AI 연구 팀, 즉 데미스 허사비스가 이끄는 런던의 딥마인드와 제프 딘이 관할하는 마운틴뷰의 구글 브레인을 따로 운영하며 귀중한 컴퓨팅 파워를 각기 다른 목표에 쓰고 있었습니다.”

“제미나이를 만들기 위해 합쳐진 두 AI 연구소는 성향이 달라 보였습니다. 알파벳의 “기타 투자(Other bets)”로 분류되던 딥마인드는 장기적인 과학 및 수학 난제 해결에 집중했습니다. 반면 구글 브레인은 지메일 자동 완성이나 모호한 검색어 해석 등 상업적으로 실용적인 혁신을 개발해왔습니다. 브레인의 총괄자 제프 딘이 “사람들이 자기 일을 하도록 두는” 스타일이었다면, 데미스 허사비스의 딥마인드 그룹은 “한 명의 장군 아래 일사불란하게 움직이는 군대 같았다”고 전직 고위 엔지니어는 말합니다. 딘이 수십 년간 신경망을 구축해온 ‘엔지니어 중의 엔지니어’였다면, 허사비스는 회사의 비전가였습니다. 그는 AI로 질병을 치료하는 꿈을 꾸었고, 사용자의 삶 전반을 돕는 보고 듣는 AI 비서, 즉 그가 말하는 “상황 인지 지능형 에이전트(situated intelligent agent)” 개발을 소규모 팀에 맡겼습니다.”

“새로운 통합 조직인 구글 딥마인드(GDM)의 CEO는 허사비스가 맡았습니다. 구글은 2023년 4월, OpenAI의 추가 성과에 대한 소문이 무성한 가운데 합병을 발표했습니다. “목표 의식이 돌아왔습니다.” 전직 고위 엔지니어가 말했습니다. “장난 칠 시간은 없었습니다.” 제미나이 모델을 최대한 빨리 만들기 위해 일부 직원들은 8개 시간대에 걸쳐 업무를 조율해야 했습니다. 수백 개의 채팅방이 생겨났습니다. 런던에서 가족과 저녁을 먹고 새벽 4시까지 일하는 데 익숙했던 허사비스는 “하루하루가 거의 평생처럼 느껴진다”고 회상합니다.”

Nvidia Earnings; Power, Scarcity, and Marginal Costs; OpenAI Hand-wringing - Stratechery

제미나이3가 만족스러워서 구글 칭찬을 많이 했으나, 나는 그래도 여전히 OpenAI 미래에 대해서는 ’매우 긍정적’으로 바라보고 있다. (물론 지금 시장은 구글과 TPU에 엄청나게 진심이 된 것 같지만...)

“그런 맥락에서, 저는 지난 며칠 동안 OpenAI에 대한 우려가 좀 지나치다고 생각합니다. 첫째, 사람들이 제미나이 3를 테스트해 본 결과, 완벽한 모델이 아니라는 것이 분명해졌습니다. 특히 GPT-5.1 Thinking보다 환각 현상이 훨씬 심하고 지시를 잘 따르지 못하는 것 같습니다. 실제로 위에서 언급한 바와 같이, 가장 큰 개선점들은 개발에 투입된 엄청난 규모와 관련 컴퓨팅 파워에서 직접적으로 기인한 것으로 보입니다. 이는 엔비디아 강세론을 재확인시켜 줄 뿐만 아니라, OpenAI(그리고 앤스로픽, xAI 등)의 향후 모델들도 큰 도약을 이룰 것임을 시사합니다. 특히 블랙웰로 훈련될 모델들은 더욱 그렇습니다(GPT-5는 호퍼로 훈련됨).”

“그러나 더 중요한 것은 희소 자원에 대한 논점입니다. 이 경우 희소 자원은 소비자의 주의(attention)입니다. 어쨌든 챗GPT는 여전히 앱 스토어에서 1위를 차지하고 있으며, 제 생각에는 기본적으로 모든 면에서 훨씬 더 나은 제품으로 남아 있습니다. 제미나이의 진짜 킬러 사용 사례는 확실히 멀티모달입니다. ‘나노 바나나’가 제미나이 3 이전부터 제미나이의 견고한 상승세를 이끈 이유이기도 합니다. 텍스트의 중요성이 줄어드는 정도(이는 특히 소비자 시장의 역사적 추세이기도 함)만큼 OpenAI가 사용자를 잃을 위험이 있습니다. 하지만 현재로서는 바이럴에 의한 대규모 전환을 일으킬 만한 요소가 부족해 보입니다. 즉, 압도적인 차이로 가장 많이 사용되는 AI 제품인 챗GPT는 안전해 보입니다.”

“물론 이것들은 매우 단기적인 관찰입니다. 구글의 구조적 이점은 여전히 막강하며, 멀티모달이라는 장기적 추세는 구글에 유리합니다. 하지만 OpenAI의 가장 큰 문제는 스스로 자초한 것입니다. 에릭 소퍼트(Eric Seufert)와 제가 목요일에 한탄했듯이, 광고 지원 버전을 출시하기를 계속 꺼리는 것은 장기적인 수익 잠재력을 지연시킬 뿐만 아니라, 사용자가 전환하거나 최소한 가능성을 열어두게 만드는 유인을 제공하고 있습니다. 아무도 월 20달러를 내거나 사용량 제한에 걸리고 싶어 하지 않습니다. 이러한 유인을 피하면서 컴퓨팅 비용을 충당하는 방법은 다른 누군가, 즉 광고주가 비용을 지불하게 만드는 것입니다. 필요한 규모로 이를 수행하는 데는 오랜 시간이 걸릴 것이므로, 시작했어야 할 시점은 챗GPT 출시 후 몇 달 이내였어야 했습니다. 그다음으로 가장 좋은 시점은 바로 지금입니다.”

“물론 이 모든 것이 궁극적으로 ‘샘의 지출’에 대한 의문을 해소해 주지는 못합니다. 그 지출이 장기적인 의문을 불러일으켰다면 회의론이 커지는 것은 타당합니다. 하지만 결론적으로 구글을 배제했던 것이 명백한 실수였던 것처럼, 지금 OpenAI나 엔비디아에 대해 섣부른 판단(끝났다는 식의)을 내리는 것 또한 비슷한 실수가 될 것이라고 생각합니다.”

Google, Nvidia, and OpenAI - Stratechery

OpenAI Code Red, AWS and Google Cloud Networking - Stratechery

벤 톰슨은 OpenAI에 대해서 광고 비즈니스를 도입해야한다고 지속적으로 주장하고 있는데,

“LLM 답변은 모델 제작자가 손에 넣을 수 있는 모든 지식의 통계적 합성물이며, 모든 개인에게 완전히 고유합니다. 동시에 모든 개별 사용자의 사용은 이론적으로 시간이 지남에 따라 모델을 더 좋게 만듭니다. 따라서 챗GPT는 당연히 광고 모델을 가져야 합니다.”

“이것은 단순히 돈을 벌어야 하는 필요성 때문만이 아닙니다. 광고는 챗GPT를 더 나은 제품으로 만들 것입니다. 더 많은 사용자가 더 많이 사용하여 더 많은 피드백을 제공하게 될 것입니다. 제휴 링크가 아니라 개인화된 광고에서 오는 구매 신호를 포착하면 개별 사용자에 대한 이해도가 풍부해져 더 나은 응답을 가능하게 할 것입니다. 그리고 보너스로 OpenAI의 해자를 극적으로 깊게 만들 것입니다.”

“구글의 수년 간의 모든 혁신을 뒷받침하고 오늘날의 거대 기업으로 만든 것은 벤처 캐피털 자금이 아니라 검색 수익이었습니다. 그런 관점에서 볼 때, 이제 3년이 된 챗GPT에 대해 광고 상품을 출시하고 반복(iterate)하기를 거부하는 OpenAI의 태도는 비즈니스 의무 태만입니다.”

“OpenAI가 성장이나 참여 시간 측면에서 심각한 문제를 겪고 있다면, 그것부터 고쳐야 합니다. 다른 모든 것은 그에 비하면 사소하며, 특히 도입 시점에 사용자에게 거부감을 줄 수 있는 광고 상품도 마찬가지입니다. 정말 실망스러운 점은 광고 상품이 없는 상태에서 2025년에 이 지경까지 왔다는 것입니다. ChatGPT는 제미나이가 좋아지기 전에 광고 기반 모델을 구축했어야 했습니다.”

OpenAI CEO Declares ‘Code Red’ to Combat Threats to ChatGPT, Delays Ads Effort - The Information

이번 유출된 ‘코드 레드’ 내용에 따르면 OpenAI는 광고 비즈니스 도입을 검토 중에 있었으나 제미나이3로 인해 ‘사용량 회복’이 최우선순위가 되며 타임라인이 늦춰졌음을 알 수 있다.

만약 OpenAI의 광고 도입 타이밍이 이미 늦은 것이라고 가정한다면, 정말로 구글에게 역전을 당했다고 볼 수 있는걸까?

즉, 앞으로 ChatGPT가 사용량을 회복하고, 이후 성공적으로 광고 비즈니스를 도입하는지가 관찰의 주요 포인트가 될 수 밖에 없다.

물론 나는 OpenAI가 이걸 어렵지 않게 해낼꺼라고 생각하긴 한다. 애초에 이런거 하라고 Fidji Simo를 CEO로 앉혀놨잖아?

참고) 현재 OpenAI 어플리케이션 부문을 책임지고 있는 피지 시모는 페이스북 앱을 담당하며 모바일 광고 비즈니스를 안착시킨 사람이며, 이후 인스타카트에서 또한 광고 모델을 붙여 수익화를 해낸 인물이다.

“알트만은 OpenAI가 광고 도입과 같은 다른 계획들을 연기할 예정이라고 말했습니다. OpenAI는 광고 판매 작업을 진행 중이라고 공개적으로 인정하지 않았지만, 해당 계획을 잘 아는 소식통에 따르면 온라인 쇼핑 관련 광고를 포함해 다양한 유형의 광고를 테스트하고 있습니다.”

“알트만은 챗GPT 개선을 위한 코드 레드 차원의 “총력전(surge)”은 쇼핑 및 건강 관련 작업을 자동화하는 AI 에이전트와, 매일 아침 챗GPT 사용자에게 맞춤형 보고서를 생성해주는 ‘펄스(Pulse)’ 같은 다른 제품들의 진행 또한 지연시킬 것임을 의미한다고 말했습니다.”

“알트만은 내부 슬랙메모에서 더 많은 직원들에게 챗GPT의 기능 개선에 집중하도록 지시하고 있다고 말했습니다. 여기에는 매주 챗GPT를 사용하는 8억 명 이상의 사람들을 위해 챗봇을 개인화하는 기능, 즉 사용자가 자신과 상호작용하는 방식을 각자 맞춤 설정할 수 있게 하는 기능 등이 포함됩니다.”

Satya Nadella describes how lessons from Microsoft’s history apply to today’s boom - Stripe

사티아 나델라는 앞으로 기업들이 각자 고유한 파운데이션 모델(또는 이에 준하는 지능 레이어)을 갖추게 될 것이며, 각자 회사의 암묵지는 사람들의 머리와 문서뿐 아니라 모델의 가중치·임베딩 형태로도 축적될 것이라고 보고 있네. 흥미로운 관점이다.

“AI 시대에는 저도 “주권”이라는 걸 조금 다르게 생각하게 됐다는 겁니다. 그게 무슨 뜻이냐 하면, 궁극적인 주권의 문제는 “기업의 미래가 무엇인가?”에 더 가깝다는 거예요. 예를 들어, 코스의 정리(Coase theorem)의 핵심으로 돌아가 보면 이런 생각이 들죠. “잠깐만, 모델이 모든 걸 아는 존재라면, 나는 도대체 왜 조직이라는 걸 가져야 하지? 원래는 내가 어떤 암묵지(tacit knowledge)를 가지고 있기 때문에, 시장에서 거래하는 것보다 조직 내부에서 거래 비용이 더 낮아지는 게 회사의 존재 이유였잖아?” 이런 고민을 하게 되죠. 꽤 머리를 흔드는 질문입니다.”

“그래서 제가 요즘 생각하는 것 중 하나는, 진짜 중요한 “주권”은 모델이 계속 학습하면서 수익·효용이 체증하는 시대에 “회사 자체의 주권”이라는 겁니다. 점점 이런 생각을 하게 돼요. 한 회사가 지능 레이어를 하나 갖고 있는데, 그게 일종의 스캐폴드(scaffold)처럼, 혹은 모델 안에 직접 박힌 가중치(weights) 형태로 존재하는 거죠. 그러니까 “남의 파운데이션 모델을 쓰느냐 마느냐”의 문제가 아니라, “그 파운데이션 모델에 대해 내가 주권을 가지고 있느냐”가 핵심이라는 겁니다.”

“제가 새로 생각하는 개념은 이래요. 미래의 회사란, 그 회사만의 파운데이션 모델을 가지고 있고, 그 모델이 회사의 암묵지를 캡처해서 조직 안에서 지식이 축적되고 퍼져나가는 데 들어가는 거래 비용을 낮춰주는 존재라는 겁니다.”

Microsoft, NVIDIA and Anthropic announced new strategic partnerships.

마이크로소프트와 OpenAI의 관계성, 그리고 마이크로소프트의 전략(모델은 거들 뿐, 돈은 인프라와 앱에서 번다)을 고려하면 앤트로픽과 손을 잡는건 너무나도 합리적이다.

“Anthropic은 300억 달러 규모의 Azure 컴퓨팅 용량을 구매하고 최대 1기가와트의 추가 컴퓨팅 용량 계약을 체결하기로 했습니다. (블랙웰 + 베라 루빈)”

“NVIDIA와 Microsoft는 Anthropic에 각각 최대 100억 달러와 최대 50억 달러를 투자하기로 약속했습니다.”

모델 전쟁과 CAPEX에 관한 좋은 의견. 아주 흥미롭게 읽었다.

다만 개인적인 생각으로는 이미 어느정도 정리가 끝나서 OpenAI, Anthropic, Google 세 개의 업체만 남은거고 (xAI는 잘 모르겠다.) 이들이 계속해서 쩐의 전쟁을 이어나갈 것이라고 보긴 하지만 (이들에 한정해서는 계속해서 누군가는 돈을 대줄 수 있다고 보고), 만약 누군가라도 전쟁에서 밀려난다면... 시장에서 큰 반응이 올 것 같긴 하다.

그럼에도 불구하고 나는 반대로 OpenAI가 무지막지한 쩐의 전쟁을 펼치면서 그만큼 판이 커질 수 있다고 생각한다. 지금 이상으로.

시장의 색깔이 바뀌고 있음이 느껴지는 요즘인데, 이를 ‘AI 모델사들이 현재 풀고 있는 문제’ & ‘AI 훈련에서 추론의 시대로 진입’의 관점으로 해석해보면 새로운 뷰가 보이는 것 같기도 하네. 어쩌면 이에 대한 해석이 내년도 AI 투자에 있어서 가장 중요할지도.

“LLM의 현재 가장 큰 한계는 ‘지속학습’입니다. 대화 세션이나, 작업물을 통해 ‘새롭게’ 데이터를 얻어내도 그걸 학습해내지 못합니다. 하지만, 이 역시도 15년~20년간을 AI 필드에서 일해온 안드레 카파시가 감으로 외삽한 결과, 10년이면 해결될 문제로 파악하고 있죠.”

“그럼 생각해봅시다. 인간 수준의 지능에 도달한 모델이, 지속학습을 해결했다고 가정하면, 그 모델은 “일하면서 계속해서 학습하는 능력”을 갖추게 됩니다. 동일한 모델의 복사본이 경제 전반에 널리 배포되어 각각의 직무를 수행하며 ‘이것은 이렇게, 저것은 저렇게’ 일하는 것이 효율적이구나, 학습하게 됩니다. 그리고 그렇게 학습되어 업데이트된 각각의 모델들은 중앙에서 또다시 하나의 모델로 통합됩니다. 이렇게되면 현장에서 학습하는 피드백 루프가 지수적으로 강화되는 것이죠. 이는 일종의 ‘산업’에서의 지능폭발입니다.”

“레오폴드(situational awareness)는 엔비디아에는 반도체 인덱스에 숏을 치면서 부정적으로 보고, ASIC 칩을 담당할 브로드컴 비중은 늘리면서 냉각 기업들을 줄인 것. 이것들의 의미는 -> 스케일링 법칙을 밀어부치는 기존의 AI 연구소 방식에 회의적이라는 것을 의미합니다. 더 큰 데이터센터와, 더 커다란 칩간의 인터커넥트 기술의 엔비디아, 그리고 랙에 올려진 수많은 GPU를 냉각하기 위한 설비들. 이들이 의미하는 것은 대규모 사전학습입니다. 하지만 ASIC 칩과 데이터센터용 유틸리티 기업들에 투자하는 것은 ‘앞으로 더 추론쪽으로 쏠릴 것’이라 판단한 것이죠.”

“우린 하나 새로운 시나리오를 생각해볼 수 있습니다. 현재의 LLM은 비터레슨을 ‘빗겨가고’ 있습니다. 더 큰 컴퓨팅, 더 큰 데이터를 집어넣으면 지능이 선형적으로 증가한다라는 이 비터레슨을 말이죠. 그렇게 파라미터의 수가 커지려면 엔비디아의 가장 중요한 핵심인 gpu간의 인터커넥트 기술, NVlink가 매우 중요한데 현재의 추세는 더 ‘작은’ 증류모델과 그 위에 수작업으로 덧대는 RL 환경입니다. 이러한 강화학습 방식에는 굳이 NVlink와 같은 수많은 gpu간의 인터커넥트 기술이 필요하지 않습니다. 그렇다는 이야기는 좀 더 ASIC 칩에 대한 수요도 많아질 것이며, 엔비디아의 경쟁사들의 부상이 손쉬워진다는 이야깁니다.”

“컴퓨팅이 점진적으로 증가한다면, 우린 안드레 카파시의 가정이 옳다고 생각하고 그에 맞는 사회변화를 외삽하는 것이 맞을 것입니다. 어느날 갑자기 마법같은 알고리즘이 나타나 세상을 놀라게하는 것이 아닌, 지금처럼 서서히 좋아지는 모델들과 점차 해결되는 지속학습, 다양한 산업에서 인간지능과 함께 결합되어 AI가 사용되는 하이브리드적인 미래가 한동안 지속된다고 보는 것이 가장 합리적일 것입니다.”

Thinking through how pretraining vs RL learn - Patel

강화학습에 대한 드와케시 파텔의 최근 글인데, 제미나이 3에게 ‘이게 무슨 내용이고 어떤 시사점을 내포하고 있는거야?’라고 질문한 답변:

① “RL은 지식을 가르치는 게 아니라, 잠재력을 깨우는 것이다”

내용: RL은 정보 밀도가 낮기 때문에, 모델이 아예 모르는 지식을 RL로 가르치려 하면 실패합니다.

시사점: 이것이 바로 “강력한 사전 학습(Pretraining)이 선행되어야 하는 이유”입니다. RLVR(검증 가능한 보상 기반 RL)은 모델이 이미 사전 학습 때 배운 방대한 지식 조각들을 ‘어떻게 연결하고 검증할지’ 그 태도와 전략을 가르치는 과정입니다. 즉, ‘공부’는 사전 학습 때 하고, RL 때는 ‘시험 잘 보는 요령’을 익히는 셈입니다.

② “Self-Play(셀프 플레이)가 왜 필수적인가?”

내용: 글에서는 학습 효율이 좋은 ‘골디락스 존(승률 50%)’을 언급합니다.

시사점: 알파고나 최근의 추론 모델들이 Self-Play를 도입하는 수학적 이유가 여기 있습니다. 나와 비슷한 실력의 상대와 싸우면 승률이 항상 50% 근처로 유지되므로, RL의 정보 습득 효율(Bits/Sample)을 인위적으로 최대치로 끌어올릴 수 있기 때문입니다. 이것이 난이도를 점진적으로 올리는 커리큘럼 학습이 RL에서 필수적인 이유이기도 합니다.

③ “현재의 추론 모델은 ‘가짜 똑똑이’일 수 있다 (The Jaggedness)”

내용: 모델이 코딩 대회 문제는 기가 막히게 풀지만, 뻔한 버그를 만들거나 기술 부채를 남기는 ‘불균형(Jaggedness)’을 보입니다.

시사점: 현재의 RL 방식은 모델에게 진정한 ‘일반적 사고력(General Reasoning)’을 길러주는 게 아니라, “이런 유형의 문제는 이런 템플릿으로 푼다”는 휴리스틱(Heuristic)을 과적합(Overfitting)시키고 있을 가능성이 큽니다. 이는 현재 AI 모델들이 보여주는 추론 능력의 취약성을 지적합니다.

④ “결국엔 ‘과정 보상(Process Reward)’과 ‘세계 모델(World Model)’이 필요하다”

내용: 마지막 결과만 보는 RL(Outcome-based)은 비효율적입니다. 중간 과정이 맞았는지 틀렸는지 알려주는 것(Process Reward)이나, 인간처럼 결과와 상관없이 관찰만으로 배우는 방식이 필요합니다.

시사점: 향후 AI 연구의 방향성은 단순히 RL의 규모를 키우는 것이 아니라, 과정 보상 모델(PRM)의 고도화나 인간의 학습 방식을 모사한 새로운 학습 패러다임(World Models)으로 나아가야 함을 시사합니다. 인간은 실패한 사업 경험에서도 단순히 “망했다”는 1비트 정보 외에 수만 가지 깨달음을 얻기 때문입니다.

이어서 ‘이 내용을 기반으로 한 투자에 대한 시사점이나 인사이트도 있으려나?’라고 질문한 답변:

1. 인프라(H/W) 관점: “Inference(추론) 컴퓨팅의 폭발적 수요”

이 글에서 가장 강조하는 것은 **”RL은 샘플 하나를 얻기 위해 수만 토큰을 생성(Unroll)해야 한다”**는 점입니다. 이는 기존 학습(Training) 단계뿐만 아니라, 모델을 강화하고 사용하는 과정에서 연산량이 기하급수적으로 늘어남을 의미합니다.

Training vs. Inference 경계의 붕괴: 과거에는 ‘학습(Training)’에 막대한 GPU가 필요하고 ‘추론(Inference)’은 가벼웠습니다. 하지만 o1이나 DeepSeek R1 같은 모델은 **”생각하는 시간(Test-time compute)”**을 늘려 성능을 높입니다.

→ 단순히 모델을 훈련시키는 칩뿐만 아니라, 추론 전용 칩(ASIC)이나 추론 효율성을 극대화하는 메모리(HBM 등) 솔루션을 가진 기업의 가치가 더 오래 지속될 것입니다.

→ 전력 소비 급증: RL 과정(Self-play 등)이 상시화되면 데이터센터 전력 밀도는 더 높아져야 합니다. 전력 인프라 및 쿨링 관련 기업(Cooling solutions, Utilities)의 수혜가 예상보다 길어질 수 있습니다.

2. 모델 경쟁력(Moat) 관점: “사전 학습(Pretraining)의 해자는 여전히 깊다”

글의 핵심 논지는 **”RL은 없던 지능을 만드는 게 아니라, 사전 학습된 모델의 잠재력을 끄집어내는 것일 뿐”**이라는 것입니다. 즉, ‘기초 체력(Pretraining)’이 부실하면 아무리 RL을 돌려도 소용없다는 뜻입니다.

후발 주자의 진입 장벽: 벤치마크 점수를 빠르게 올리기 위해 RL만 강조하는 후발 주자나 소형 모델 스타트업은 한계에 봉착할 가능성이 큽니다. 방대한 데이터로 제대로 된 사전 학습을 수행할 자본과 인프라를 갖춘 **빅테크(OpenAI, Google, Anthropic 등)**의 해자는 생각보다 견고합니다.

→ “우리 모델이 RL로 빅테크를 이겼다”고 주장하는 소형 AI 모델 기업을 볼 때, 그 성능이 ‘특정 벤치마크 과적합(Overfitting)’인지 아니면 ‘진짜 일반 지능(Base Capability)’인지 냉정하게 평가해야 합니다. 기반 모델(Foundation Model)의 퀄리티가 떨어지는 기업은 투자 매력도가 낮습니다.

3. 데이터 밸류체인 관점: “고품질 평가(Evaluation) 데이터가 새로운 석유”

글에서는 RL의 비효율성을 극복하기 위해 **’과정 보상 모델(Process Reward Model)’**이나 **’대리 평가(Proxy Evaluation)’**가 필요하다고 언급합니다. 즉, “결과만 O/X”로 알려주는 데이터는 가치가 떨어지고, “과정이 논리적인가?”를 판단해 주는 데이터가 핵심이 됩니다.

→ 단순 텍스트 데이터 수집(Crawling) 기업보다는, 전문가 레벨의 고품질 라벨링(Reasoning Trace 작성)을 수행하는 데이터 기업이나, 모델의 성능을 정교하게 평가(Eval)하는 솔루션을 가진 기업의 가치가 상승할 것입니다. (예: Scale AI 같은 기업의 비즈니스 모델이 더욱 고도화될 필요성)

4. 리스크 관리 관점: “Jaggedness(능력 불균형)와 상용화 지연”

글에서 지적한 **’불균형(Jaggedness)’**은 투자자에게 중요한 리스크 요인입니다. *”코딩 대회는 1등인데, 뻔한 버그를 못 잡는 모델”*은 실제 기업 현장(B2B)에 바로 투입하기 어렵습니다.

환멸의 계곡(Trough of Disillusionment) 주의: 현재의 RL 기반 추론 모델들이 벤치마크상으로는 인간을 넘었지만, 실제 서비스(Agent)로 구현했을 때 신뢰성(Reliability) 문제로 인해 상용화가 예상보다 늦어질 수 있습니다.

→ AI 에이전트(Agent) 기업에 투자할 때, 단순히 “최신 모델을 쓴다”는 것보다 **”모델의 불균형한 실수를 보완할 안전장치(Guardrail)나 인간 개입 프로세스(Human-in-the-loop)를 얼마나 잘 갖췄는가?”**가 기업의 생존을 가를 것입니다. 완전 자율 AI보다는 ‘하이브리드’ 접근을 하는 기업이 단기적으로는 실적을 낼 확률이 높습니다.

최종 요약: “GPU 수요는 추론(Inference) 영역으로 확장되면서 더 오래갈 것이고(Long Hardware), 모델 기업은 기초 체력(Pretraining)이 튼튼한 소수 승자독식으로 흐를 것이며(Long Big Tech), 어설픈 AI 에이전트 서비스 기업은 신뢰성 문제로 옥석 가리기가 심화될 것이다(Short/Caution on Thin Wrapper Applications).”

Thoughts on AI progress (Dec 2025) - Patel

드와케시 파텔은 지금의 AI 발전으로는 AGI 도달이 꽤나 멀었다고 (10년 이상) 생각하는 것 같다.

마치 인간처럼 어느 상황이든 바로 상황을 이해할 수 있는 수준의 AI가 나와야 한다고 이야기하고 있고, 이는 곧 일리야의 접근처럼 ‘완전히 새로운 무언가’가 나와줘야 AGI 도달이 가능하다는 이야기이다.

(*주의: AI에 대한 회의론이 절대 아니다. 반대로 이 글은 맥락 이해가 가능한 AI가 개발되기 시작하면 또 다른 세상으로 들어설 수 있음을 암시하고 있다.)

“사람들은 대부분의 업무를 수행하는 데 있어 얼마나 많은 ‘회사 및 맥락 특화(company and context specific)’ 기술이 필요한지를 과소평가하고 있습니다. 그리고 현재로서는 AI가 그러한 기술을 습득할 수 있는 견고하고 효율적인 방법이 존재하지 않습니다.”

“인간 노동이 가치 있는 이유는 훈련시키기가 ‘번거롭지(shleppy)’ 않기 때문입니다: 인간 노동자가 가치 있는 이유는 우리가 그들의 업무의 모든 작은 부분마다 번거로운 훈련 루프를 구축할 필요가 없기 때문입니다. 특정 실험실이 슬라이드를 준비하는 방식에 따라 대식세포가 어떻게 보이는지 식별하기 위해 맞춤형 훈련 파이프라인을 구축하고, 또 다른 실험실 특유의 마이크로 작업을 위해 또 다른 파이프라인을 구축하는 식은 순생산성(net-productive)이 없습니다. 실제로 필요한 것은 인간처럼 의미론적 피드백이나 자기 주도적 경험을 통해 배우고 일반화할 수 있는 AI입니다.“

“2030년까지 연구소들이 제가 강조하는 ‘지속적 학습(continual learning)’에서 상당한 진전을 이루고 모델들이 수천억 달러의 매출을 올리기 시작하겠지만, 모든 지식 노동을 자동화하지는 못할 것이라고 예상합니다. 그때 저는 “많은 진전을 이루었지만, 아직 AGI는 아닙니다. 매출이 수조 달러에 도달하려면 X, Y, Z가 더 필요합니다.”라고 말할 것입니다. 모델들은 ‘짧은 타임라인’을 주장하는 사람들이 예측하는 속도로 더 인상적으로 변하고 있지만, 유용성 측면에서는 ‘긴 타임라인’을 주장하는 사람들이 예측하는 속도로 발전하고 있습니다.”

Andrej Karpathy — AGI is still a decade away

안드레 카파시도 파텔과 유사한 뷰를 가지고 있다. 아래는 GPT에게 정리를 부탁한 내용:

카라시의 최근 대담을 전체적으로 정리하면, 그는 AI의 기술적 진보와 인간의 역할을 동시에 바라보는 “장기적 진화론자이자 휴머니스트 엔지니어”로서의 관점을 일관되게 드러낸다. 그의 핵심 주장은 “지금은 ‘에이전트의 해’가 아니라 ‘에이전트의 10년’이다”라는 말로 요약된다. 즉, 현재의 대규모 언어모델(LLM)들은 놀랍지만, 실제로 인간의 일을 대체하거나 완전한 자율 에이전트로 신뢰받기까지는 최소 10년이 걸리는 장기 과제라는 것이다.

그는 LLM이 가진 구조적 한계를 냉정히 바라본다. 현재 모델들은 표현력은 탁월하지만, 기억을 유지하거나 도구를 조작하고, 자기 반성을 통해 스스로 개선하는 능력은 매우 제한적이다. 그는 RL(강화학습) 기반의 학습 방식이 “긴 과정 전체를 마지막 보상 하나로만 감독하는 빨대” 같다고 비유하며, 이런 비효율적 피드백 구조가 진정한 지능 발전을 가로막는다고 지적한다. 따라서 앞으로의 AI 발전은 단순한 모델 확장보다 “기억, 장문맥 이해, 도구 사용, 자기반성 루프” 같은 에이전트 스택 전반의 완성에 달려 있다고 본다.

그는 특히 “코딩이 AI 자동화의 첫 번째 도메인”이라는 점을 강조한다. 코드는 텍스트 기반이면서 이미 IDE·diff·버전 관리 등 자동화를 위한 생태계가 잘 갖춰져 있다. 반면 슬라이드, 영상 편집, 시각적 디자인 등은 비정형 데이터로 이루어져 있어 적용이 어렵다. 따라서 현재 AGI의 ‘첫 실질적 파급’은 코딩이며, 이는 LLM의 본질적 강점인 텍스트 처리와 완벽히 맞아떨어지는 영역이라는 것이다.

카라파티는 기술 발전을 과장하거나 신비화하지 않는다. 그는 “데모와 제품은 다르다”는 점을 자율주행 경험을 통해 배웠다고 말한다. 1980년대부터 자율주행의 ‘완벽한 데모’는 존재했지만, 현실화에는 수십 년이 걸렸다. 그는 이를 ‘Nine의 행진(March of 9s)’이라 표현하며, 정확도를 90%에서 99%로 올리는 데와 99%에서 99.9%로 올리는 데 필요한 노력이 거의 동일하다고 설명한다. AI 제품화도 마찬가지로, “데모에 감동하는 사람일수록 현실을 모르는 사람”이라고 단언한다.

경제적 시각에서 그는 AGI가 초고속 성장을 이끌 것이라는 ‘지능 폭발(intelligence explosion)’론에 회의적이다. 역사적으로 산업혁명, 전기, 인터넷, 스마트폰 같은 혁신들도 모두 GDP 성장률 2%라는 일정 궤도 위에 녹아들었으며, AGI 역시 기존의 지수적 곡선을 따라 점진적으로 확산될 가능성이 높다고 본다. 그는 “AI는 새로운 산업혁명이 아니라 기존 자동화의 연장선”이라며, 갑작스러운 20% 성장률의 경제 도약보다는 “천천히, 그러나 끊임없이 상승하는 지능의 곡선”을 현실적 시나리오로 본다.

진화론적 관점에서 그는 지능의 출현 자체를 “매우 희귀한 사건”으로 본다. 지구 생명사 40억 년 중, 인간형 지능은 극히 최근에 나타났기 때문이다. 그는 “조류나 인간처럼 독립적으로 고등지능이 생긴 경우가 있지만 매우 드물다”며, LLM에는 아직 인간이 가진 ‘문화(culture)’의 자기축적 메커니즘이 없다고 지적한다. 인간은 기록과 전승을 통해 지식을 누적하지만, LLM은 서로에게서 배우지 않는다. 그는 “왜 LLM이 다른 LLM을 위해 책을 쓰지 못하는가?”라고 묻는다. 향후 AI가 문명 수준으로 진화하려면 ‘LLM 간의 자기학습(Self-Play)’과 ‘지식 공유 문화’가 필수적이라 본다.

AI 인프라 확장에 대해서는 그는 신중한 낙관론자다. GPU 공급 확대와 데이터센터 증설이 과열처럼 보일 수 있지만, 결국 AI 수요가 이를 흡수할 것이라고 본다. 다만, 현재 시장의 과도한 낙관은 “실제 기술 이해보다는 펀드레이징과 관심경제의 부산물”이라 비판하며, 기술적 현실 감각을 되찾아야 한다고 강조한다.

그의 철학은 기술에 그치지 않고 인간으로 확장된다. 그는 현재 AI 연구에서 잠시 물러나 ‘Eureka’라는 교육 프로젝트를 시작했다. 목표는 “AI 시대의 스타플릿 아카데미(Starfleet Academy)”를 세우는 것이다. 단순한 코스 제작이 아니라, “AI를 사용하는 인간의 학습 능력을 업그레이드하는” 교육을 설계하려는 시도다. 그는 완벽한 개인화 튜터를 AI로 구현하는 것이 최종 목표지만, 아직은 인간 튜터의 수준에 한참 미치지 못한다고 말한다. 대신 현재는 ‘NanoChat’ 같은 미니 프로젝트를 통해 학습자에게 ‘Eureka 순간(이해의 순간)’을 극대화하는 지식 램프(ramp to knowledge)를 만드는 데 집중하고 있다.

그는 “포스트 AGI 시대의 교육은 생존이 아닌 재미를 위한 것이 될 것”이라고 본다. AI가 모든 실용적 업무를 수행하게 되면, 인간은 배움을 ‘헬스장처럼’ 즐길 것이다. “지식의 근육을 키우는 일은 여전히 인간에게 매력적이며, 사람들은 단지 즐거움과 자기실현을 위해 학습할 것”이라는 것이다. 그는 이러한 학습이 인류의 존엄을 지키는 유일한 방법이라 믿는다. “만약 우리가 ‘WALL-E’나 ‘Idiocracy’의 인간 퇴화 시나리오로 가게 된다면, 아무리 거대한 다이슨 스피어를 지어도 의미가 없다”고 단언한다.

마지막으로 그는 좋은 교육이란 “지식을 쌓는 게 아니라, 학습자가 스스로 걸어갈 수 있도록 지식을 계단처럼 설계하는 기술적 문제”라고 정의한다. 자신의 물리학 훈련을 바탕으로, 복잡한 개념을 1차 근사(본질)로 단순화하고, 학습자가 직접 ‘통찰의 순간’을 느끼도록 설계하는 것이 핵심이라고 말한다. “micrograd” 같은 100줄짜리 코드가 신경망의 본질을 보여주듯, 교육도 최소 단위의 원리로부터 시작해야 한다는 것이다.

요약하자면, 카파시는 기술적 과열 속에서 “데모와 과장”을 경계하고, 인간이 여전히 주체로 남기 위한 방법을 모색하는 사상가에 가깝다. 그는 AI를 “대체 기술”이 아니라 “증폭 기술”로 정의하며, 지금 우리가 해야 할 일은 더 크고 똑똑한 모델을 만드는 것이 아니라, 인간이 그 모델과 함께 성장할 수 있는 “지능적 사회의 학습 구조”를 설계하는 것이라고 본다. 결국 그가 제시하는 메시지는 하나다. “지금은 대체의 시대가 아니라 증폭의 시대이며, 진짜 승자는 에이전트를 만드는 팀이 아니라, 에이전트를 이해하고 활용할 수 있는 인간이다.”

Ilya Sutskever – We’re moving from the age of scaling to the age of research

최근 일리야 인터뷰는 최근의 그 어떤 인터뷰보다 밀도가 높은 것 같은데... 미래에 대한 힌트가 가득하다.

“사람들이 무심코 저지르는 실수 중 하나는 평가(evals)에서 영감을 얻는 거예요. “우리 모델이 출시됐을 때 평가 점수가 좋았으면 좋겠어. 이 작업에 도움이 될 RL 훈련이 뭘까?” 이런 일이 실제로 일어나고, 이게 지금 벌어지는 많은 현상을 설명해 줄 수 있다고 봅니다.”

“도움이 될 만한 인간 비유가 있어요. 코딩 대회를 언급했으니 그 예로 들어보죠. 두 명의 학생이 있다고 칩시다. 한 명은 최고의 코딩 대회 선수가 되기로 결심하고 그 분야만 1만 시간을 연습했어요. 모든 문제를 풀고, 모든 증명 기법을 암기하고, 모든 알고리즘을 빠르고 정확하게 구현하는 데 도가 텄죠. 그렇게 해서 최고 중 하나가 됐어요. 두 번째 학생은 “오, 코딩 대회 재밌네” 하고 100시간 정도, 훨씬 적게 연습했는데도 성적이 아주 좋았어요. 나중에 커리어에서 누가 더 잘할 것 같으세요?”

“(두 번째 학생이요) 맞아요. 제 생각엔 그게 지금 벌어지고 있는 일의 본질이에요. 모델들은 첫 번째 학생에 훨씬 가깝고, 심지어 그보다 더해요. 우리는 “모델이 코딩 대회를 잘해야 하니까 모든 코딩 대회 문제를 다 긁어모으자. 그리고 데이터 증강을 해서 더 많은 문제를 만들고 훈련시키자”라고 하죠. 그럼 대단한 코딩 대회 선수가 탄생해요.”

“사람들이 강화학습(RL)을 할 때, 지금 방식으로는 에이전트를 어떻게 훈련할까요? 신경망에 문제를 주고 “풀어봐”라고 하죠. 모델은 수천, 수십만 번의 행동이나 생각을 거쳐 해결책을 내놓아요. 그럼 그 해결책을 채점하죠. 그리고 그 점수를 사용해 궤적(trajectory)에 있는 모든 행동에 훈련 신호를 보내요. 즉, 해결하는 데 오래 걸리는 작업을 훈련시킨다면, 해결책을 내놓을 때까지는 학습이 전혀 일어나지 않는다는 뜻이에요. 이게 순진한(naive) 강화학습 방식이고, o1이나 R1이 표면적으로 수행되는 방식이죠.”

“가치 함수는 “내가 항상은 아니더라도 가끔은 네가 잘하고 있는지 못하고 있는지 말해줄 수 있어”라고 하는 것과 같아요. 가치 함수의 개념은 특정 영역에서 더 유용해요. 예를 들어 체스를 두다가 기물을 잃으면 “망했네”라고 알 수 있잖아요. 게임이 끝날 때까지 갈 필요 없이 방금 한 행동이 나빴고, 그전 행동들도 나빴다는 걸 알 수 있죠. 가치 함수는 맨 끝까지 기다리는 과정을 단축해 줘요. 수학이나 프로그래밍 문제를 풀면서 특정 해결책을 탐색한다고 치죠. 한 1,000단계 생각한 뒤에 “이 방향은 가망이 없다”고 결론 내렸어요. 그 결론을 내리는 즉시, 1,000단계 전 이 경로를 선택했을 때로 돌아가서 보상 신호를 줄 수 있어요. 실제로 해결책을 내놓기 훨씬 전에 “다음번에 비슷한 상황이 오면 이 길로 가지 말아야지”라고 학습하는 거죠.”

“트위터 등에서 들리는 말로는 제미나이(Gemini)가 사전 학습에서 더 많은 걸 뽑아내는 방법을 찾은 것 같기도 해요. 하지만 언젠가 사전 학습 데이터도 바닥날 겁니다. 데이터는 명백히 유한하니까요. 그럼 그다음엔요? 이전과 다른 강화된 사전 학습 레시피를 쓰거나, RL을 하거나, 다른 걸 하겠죠. 하지만 이제 컴퓨팅 규모가 너무 커졌어요. 어떤 면에서는 다시 ‘연구의 시대’로 돌아온 겁니다.”

“제가 생각하는 가장 근본적인 문제는, 이 모델들이 인간보다 극적으로 일반화(generalization)를 못한다는 겁니다. 아주 명백해요. 그게 아주 근본적인 문제 같아요.”

“(물론 언어, 수학, 코딩 능력 자체는 모델이 평균적인 인간보다 뛰어나죠. 하지만 학습 능력(learning)도 모델이 인간보다 뛰어난가요?) 오, 그렇죠. 절대적으로 그래요. 제 말은 언어, 수학, 코딩—특히 수학과 코딩—은 인간을 학습에 능하게 만드는 무언가가 복잡한 사전 지식(prior)이라기보다, 더 근본적인 어떤 원리일 가능성을 시사한다는 겁니다.”

“지난 1년 동안 제 생각이 바뀐 것 중 하나는 상상하기 어렵다면 보여줘야 한다는 겁니다. AI 연구하는 사람들도 상상 못 한다고 봐요. 제 예측은 AI가 강력해질수록 사람들의 행동이 바뀔 거라는 거예요. 전례 없는 일들을 보게 될 겁니다.”

“기업들은 무엇을 만들려고 열망해야 할까요? 모두가 꽂혀 있는 하나의 큰 아이디어는 ‘자기 개선(self-improving) AI’예요. 왜요? 회사보다 아이디어가 적으니까요. 하지만 저는 더 나은 목표가 있다고 봅니다. ‘지각 있는 생명체(sentient life)를 아끼도록 튼튼하게 정렬된 AI’입니다. 특히 인간 생명만 아끼는 AI보다 지각 있는 생명체를 아끼는 AI를 만드는 게 더 쉬울 수 있어요. AI 자체도 지각이 있을 테니까요. 거울 뉴런이나 동물을 향한 인간의 공감 같은 걸 생각해 보면, 그건 우리 자신을 모델링하는 회로를 사용해 타인을 모델링하는 데서 나오는 창발적 특성이거든요.”

(SSI는 무엇을 다르게 할 계획입니까? 다른 회사들은 모르는 안전한 접근법이 있다고 생각해서 SSI를 시작하셨을 텐데요. 그 차이가 뭡니까?)

“유망하다고 생각하는 아이디어들이 있고, 그걸 조사해서 정말 유망한지 아닌지 확인하고 싶어요. 정말 간단해요. 그 아이디어들—일반화를 이해하는 것과 관련된—이 맞다면 가치 있는 뭔가를 갖게 될 겁니다. 맞을까요? 우리는 연구를 하고 있어요. 우리는 전적으로 ‘연구의 시대’에 있는 회사예요. 지난 1년간 꽤 좋은 진전을 이뤘지만 더 많은 진전이 필요해요. 저는 이걸 목소리를 내고 참여자가 되려는 시도로 봅니다.”

“우리가 320억 달러 가치로 자금 조달 중이었는데, 메타가 인수를 제안했고 전 거절했어요. 하지만 전 공동 창업자는 어떤 의미에서 수락했죠. 결과적으로 그는 당장의 유동성을 누릴 수 있었고, SSI에서 메타로 간 건 그 사람뿐이에요.”

“(SSI만의 차별점은 뭡니까?) 가장 큰 건 기술적 접근법이에요. 우린 다른 기술적 접근법을 가지고 있고 추구하고 있어요. 결국엔 전략이 수렴할 거라고 봅니다. AI가 강력해질수록 전략이 뭐여야 하는지 명확해질 거예요. 서로 대화할 방법을 찾고, 첫 번째 초지능 AI가 정렬되어 있고 지각 있는 생명체를 아끼고 민주적인 것 등이어야 한다는 조건 말이에요. 이게 모두가 노력해야 할 조건이고 SSI가 추구하는 겁니다.

Gavin Baker and David George on Positional Strategy in AI - a16z

개인적으로 Gavin Baker의 인터뷰와 포트폴리오 (Atreides Management 13F)는 중요하게 챙겨보는 편이다. 자신만의 의견이 뚜렷한데 그 의견들이 맞을 확률이 상당히 높으며, 그래서인지 훌륭한 트렉레코드를 가지고 있기 때문이다.

“저는 2000년 버블(실제로는 통신 버블이었죠) 당시에 테크 투자자였던, 어떻게 보느냐에 따라 특권이자 불행이었던 경험이 있습니다. 오늘날과 2000년을 비교하고 대조하는 것이 도움이 된다고 생각합니다. 시스코(Cisco)는 후행 주가 수익률(trailing earnings)의 150배 또는 180배에서 정점을 찍었지만, 엔비디아(NVIDIA)는 40배 정도입니다. 즉, 밸류에이션이 매우 다릅니다.

“하지만 더 중요한 것은 2000년의 인터넷 버블 또는 통신 버블은 ‘다크 파이버(dark fiber)’라는 것으로 정의되었다는 점입니다.

“2000년대에 계셨던 분이라면 그것이 무엇인지 아실 겁니다. 다크 파이버는 문자 그대로 땅에 매설되었지만, 불이 켜지지 않은(활성화되지 않은) 광섬유였습니다. 광섬유는 양쪽에 필요한 광학 장치, 스위치, 라우터가 없으면 쓸모가 없습니다. 레벨 쓰리(Level Three)나 글로벌 크로싱(Global Crossing), 월드컴(WorldCom) 같은 회사들이 와서 “우리가 이번 분기에 20만 마일의 다크 파이버를 매설했습니다. 정말 놀랍습니다. 인터넷은 정말 거대해질 겁니다. 빨리 이것들을 활성화하고 싶습니다.”라고 말하던 것이 생생하게 기억납니다.”

“버블이 정점에 달했을 때, 미국에 매설된 광섬유의 97%가 다크 파이버였습니다. 오늘날과는 대조적입니다. 현재는 ‘다크 GPU’가 없습니다. 기술 백서를 읽어보기만 해도, 트레이닝 실행에서 가장 큰 문제가 GPU가 과도한 사용으로 녹아내리고 있다는 것을 알 수 있습니다.”

“이 모든 것의 핵심을 짚는 간단한 방법이 있습니다. 바로 GPU에 가장 많은 돈을 지출하고 있고 모두 상장 기업인 회사들의 **투입 자본 수익률(ROIC)**을 살펴보는 것입니다. 이 회사들은 설비 투자(CapEx)를 늘린 이후 ROIC가 약 10%포인트 증가했습니다. 따라서 지금까지 모든 지출에 대한 ROI(투자 수익)는 매우 긍정적이었습니다.”

Some thoughts on AI - Gavin Baker

역시 Gavin Baker 관점은 명쾌하다.

“Gemini 3는 프리트레이닝을 위한 스케일링 법칙이 여전히 유효하다는 것을 보여준다. 이는 o1이 출시된 이후 가장 중요한 AI 데이터 포인트다. 이는 곧 블랙웰 계열 모델들이 2026년 2분기에 출시될 때 성능이 크게 향상될 가능성이 높다는 뜻이기도 하다. GPT-5는 스케일링 법칙이 둔화되고 있다는 증거가 아니었다. GPT-5는 더 나은 성능을 목표로 설계된 것이 아니라, 추론 비용을 더 싸게 만드는 데 초점을 맞춘 모델이었다. 실제로는 라우터 뒤에 숨은 더 작은 모델이었다. 그리고 Gemini 3가 TPU로 학습되었으니 블랙웰과는 연결해서 해석할 수 없다고 말하지는 말아 달라. 프리트레이닝에서 중요한 것은 블랙웰이든 TPU든 상관없이 일관된(coherent) FLOPs의 규모다.”

“AI는 내가 기술 투자자로 일해 온 커리어 전체를 통틀어, “비용”이 진짜로 중요한 의미를 갖는 첫 사례로 남아 있다. 애플이 수조 달러짜리 기업이 된 이유는 아이폰을 가장 낮은 원가로 생산하기 때문이 아니며, 엔비디아가 AI 가속기를 가장 싸게 만드는 회사라서 그런 것도 아니다. 그러나 “토큰을 가장 낮은 비용으로 생산하는 플레이어”가 되는 것은 엄청난 이점을 가져올 것이다. 오늘날 토큰의 최저 비용 생산자는 구글이고, 그 다음이 xAI다. 중요한 것은 GPU나 TPU의 “대수”가 아니라, 하나의 클러스터/패브릭 내에서 일관되게(coherent) 묶여 있는 GPU의 수, 그리고 그 클러스터/패브릭 내에서 통신하는 데 드는 비용이다.”

“CoreWeave의 분기 실적은, 설령 CoreWeave가 전력 계약 측면에서 우위를 가지고 있더라도, 실제로 전력을 확보해 온·오프라인으로 만들고 인프라를 적시에 배치하는 일이 얼마나 어려운지를 보여주었다. 이런 전력 관련 병목은 앞으로 더 자주 발생해 더 많은 플레이어에게 영향을 줄 가능성이 크다. 나는 이것이 오히려 긍정적이라고 본다. 전력 부족은 AI 인프라 구축에서 자연스러운 ‘조절 장치(governor)’ 역할을 하여, 과잉 구축(overbuild)이 일어날 확률을 낮춘다. 이로 인해 사이클의 기간은 더 길어지고, 변동성은 더 완만해질 것이다.”

“전력 부족은 블랙웰에게는 훌륭한 환경이 될 수도 있다. 와트(watt)가 병목이 되는 상황에서는, 와트당 토큰(tokens per watt)이 의사결정을 좌우하게 되며, 토큰은 말 그대로 = 매출이다. 전력 제약이 심한 세계에서는 GPU vs ASIC 가격 차이는 훨씬 덜 중요해진다. 여기에 구글이 TPU를 외부 고객에게 판매하기 시작했다는 사실까지 더해지면, 다른 대부분의 ASIC 프로그램이 취소될 가능성이 크다. 설령 어떤 ASIC이 1GW급 데이터센터의 구축 비용을 500억 달러에서 400억 달러로 줄여 준다고 하더라도, 그 400억 달러의 ROI는 더 낮을 것이다. 그 데이터센터가 만들어내는 매출(토큰)이 상당히 줄어들 것이기 때문이다. 종합하면, 전력 부족은 와트당 토큰 성능이 가장 뛰어난 반도체와 시스템의 가격 결정력을 크게 높여 준다.”

“광통신(optics)은 워크로드를, 전력이 충분하고 가격이 싼 곳으로 옮길 수 있게 해준다. 전기요금 인상에 대한 정치적 압력을 완화하기 위해 출력 제한(curtailment)이 하나의 해법으로 쓰이게 되면서, 이것은 점점 더 중요해질 것이다. 멀티 캠퍼스에서 진행하는 트레이닝에는 상상을 초월하는 수준의 광통신 장비가 필요하지만, 이 지출 규모는 여전히 연산(컴퓨트)에 들어가는 지출에 비하면 훨씬 작다. 따라서 경제적으로 충분히 성립 가능한 대안이다. 역설적이게도, 광통신은 중국의 GPU 부족과 전력 과잉 문제에 대한 해법이기도 하다. 스케일-업 네트워킹에서 구리(copper) 케이블 대신 광(optical)으로 전환하면, 전력 사용량이 극적으로 늘어나는 대가를 치르는 대신, 가속기 한 개당 연산 성능 부족분 상당 부분을 상쇄할 수 있기 때문이다.”

“블랙웰이 널리 공급되기 시작한 이후에도 Hopper 임대 가격이 오히려 상승했다는 사실은, GPU 잔존가치(residual value)를 지금의 6년보다 더 길게 잡아야 할지도 모른다는 신호다. 오늘날에도 A100조차 여전히 매우 높은 수준의 변동 현금 마진(variable cash margin)을 만들어 내고 있다. 이런 추세가 이어진다면, GPU 금융 비용은 추가로 100~200bp 정도 더 낮아질 수 있다. 덧붙이자면, 데이터센터의 물리적 현실을 감안하면 GPU의 경제적 수명이 1~2년에 불과하다는 가정은 사실상 성립할 수 없다.”

“벤처 회사들이 대거 클라우드로 이전한 뒤, S&P 500 기업들이 광범위하게 클라우드로 전환하기까지는 대략 5년 정도가 걸렸다. AI는 이보다 더 빠르게 진행될 수도 있다. 3분기가, 여러 S&P 500 기업들이 처음으로 “재무제표에 눈에 보이게 영향을 준 AI 생산성 데이터”를 공개한 시점이었다는 점은 주목할 만하다. 예를 들어 C.H. Robinson 같은 사례가 그렇다. 이런 대기업들의 초기 생산성 향상은, 벤처 투자자들이 포트폴리오 회사들을 통해 보고 있는 현상과도 맞닿아 있다. 사실상 모든 벤처 지원 회사들이 AI에 과감하게 베팅하면서, 직원 1인당 매출이 수직 상승하고 있기 때문이다.”

“이 모든 것은 우리가 아직 AI의 매우 초기 단계에 있다는 점을 시사한다.”

The Benefits of Bubbles - Stratechery

결국 이번에도 버블 형성과 터짐은 필연적이겠지만, 그래도 이번 버블은 최소한 팹과 전력이라는 인프라는 남길 것이라는 주장.

(근데 이건 미국의 관점이라서, 한국의 관점에서는 AI의 버블 시기동안 무엇을 남길 수 있을지 고민해봐야할듯?)

“닷컴 버블의 경우 진짜로 중요했던 “손해 보는 투자”는, 실리콘밸리 신화에 자주 등장하는 닷컴 기업들 자체가 아니었다. 미친 듯한 IPO들에 돈을 잃은 사람이 많긴 했지만, 그 손실은 대부분 주식(지분)에서 발생했지, 부채에서 발생한 것은 아니었다. 부채가 문제였던 곳은 통신 분야였다. 이 분야에서는 수많은 기업들이 광섬유를 과도하게 깔기 위해 빚을 지다가, 실제 수요를 한참 상회하는 인프라를 구축한 뒤 줄줄이 파산했다. 그러나 그 과잉 구축된 광섬유가 오늘날 인터넷의 기반이 되었다. 그리고 그 인프라는, 그것을 지은 회사들이 파산하면서 사실상 공짜가 되었고, 그 덕분에 오늘날 인터넷 서비스들도 거의 공짜에 가깝게 제공될 수 있게 되었다.”

“AI에 쓰인 돈의 상당 부분이 GPU, 특히 엔비디아로 흘러 들어가면서 이 회사는 세계에서 가장 가치 있는 기업이 되었다. 페레즈의 관점에서 보면 문제는 이 지점이다. 이런 칩 투자는 그녀가 다룬 인프라—철도, 공장, 광섬유 등—와 비교하면 수명이 짧다. 칩은 고장 나고, 더 좋은 칩에 의해 빠르게 대체된다. 대부분의 하이퍼스케일러는 이를 5년 정도에 걸쳐 감가상각하는데, 이마저도 관대한 편일 수 있다. 무엇이 정확한 숫자이든, 칩은 수 년 후 “완전히 상각된 채로, 거의 공짜로 오래 쓸 수 있는 자산”이 아니다. 즉, 투기적 자금이 GPU에 과도하게 쏠릴수록, 이 거품은 페레즈식의 “기대 이하” 결과를 낳을 위험이 커진다.”

“다행히도, 이 거품이 꺼진다 해도 장기적으로 큰 효용을 남길 수 있는 투자 영역이 두 군데 있다.”

“첫째는 ‘팹(fab)’, 즉 칩을 실제로 생산하는 공장이다. 나는 미국의 칩 생산 능력 감소와, 세계에서 가장 지정학적으로 위험한 지역인 대만에 대한 과도한 의존도를 오랫동안 우려해 왔다. 꽤 오랫동안 이 문제를 해결하기 위한 실질적 움직임도 없어 보였다. 그러나 지금은 TSMC와 삼성 같은 파운드리들이 미국에 팹을 짓고 있고, 미국 정부는 사실상 인텔의 주주가 되어 있다.”

“둘째는 ‘전력(power)’이다. 나는 칩이 부족하고, 전력 부족은 아직 오지 않은 위협이라고 생각해왔다. 하지만 실제로는, 이미 전력이 병목이 되고 있다.”

“지금 이 상황은 몇 년 전의 테크 산업이 주지 못했던 “재미”와 “몰입감”을 준다. 거품은 결국 좋지 않게 끝나겠지만, 역사는 거기서 끝나지 않는다. 거품이 남기는 인프라와 혁신은 수십 년에 걸쳐 효용을 준다. 우리가 지금 할 수 있는 최선은, 이 광기가 “그만한 가치가 있는” 인프라와 혁신으로 이어지기를 기도하는 것뿐이다.”

최근 샘 알트만의 행보와 그로 인한 AI 버블론의 등장은 역설적이게도 시장 참여자들이 은근 바라고 있던 AI 버블을 없에버려서 오히려 시장을 건강하게 만들고 있는 것 같다.

7줄 요약 (출처: Gromit 공부방 텔레그램)

샘 알트만의 1.4조 달러·30GW ‘대규모 지출’ 발표가 기존 AI 시장의 유포리아·버블 랠리 기대를 단숨에 깨뜨리며 서사를 흥분에서 검증으로 전환시켰고, 시장은 이제 OpenAI의 수익화 능력과 생태계 전체 P&L 영향을 중심으로 관점을 재조정하기 시작.

SS(Sam’s Splurge, 샘 알트만의 1.4조 달러 대규모 지출 계획)는 ORCL-CRWV-Hyperscaler-사모 크레딧까지 연결된 AI 생태계의 과도한 상호의존성·순환 자금 구조·레버리지 노출을 드러내며 ‘Too Big To Fail’ 논쟁을 촉발했고, 실제로 ORCL·CRWV CDS 스프레드 상승과 Meta의 270억 달러 SPV 같은 구조가 크레딧 리프라이싱을 현실화함.

정부 개입 가능성 또한 샘의 “몇 달 후 이해될 것” 발언을 계기로 부각되면서, 투자자들은 이 자금 조달이 ‘추가 업사이드(gravy)’인지 ‘계획 실행에 필수적인 조건’인지 혼란을 느끼며, 실행 실패 시 생태계 멀티플 붕괴 리스크를 의식하게 되었음.

SS(Sam’s Splurge)는 원래 28-29년에 논의될 장기 리스크(전력-그리드-토지-물-지역 반발, inference의 디바이스 이동, 화이트칼라 일자리 감소에 따른 광고·소비 탄력 저하 등)를 현재 시점으로 강제로 당겨 AI 구조 전체의 지속 가능성에 대한 불확실성을 높임.

지난 2주 동안 ORCL RPO 랠리 반납, 투기적 AI 섹터 롤오버, OAI 딜 발표 효과 약화, 연준 매파 코멘트 등 가격 행동 변화가 집중적으로 나타나며 시장은 펀더멘털 변화 없이 리스크 프리미엄 재할당·멀티플 압축을 진행하는 중.

이 과정에서 부채·비즈니스 모델 리스크가 있는 이름, 고평가 서사형 성장주는 언더퍼폼한 반면 메모리처럼 구조적 EPS 상향과 스팟 가격 상승이라는 불확실성 낮은 섹터는 강세를 유지하며 ‘품질·현금흐름 중심의 리프라이싱’이 뚜렷해짐.

궁극적으로 SS(Sam’s Splurge)는 버블을 터뜨린 것이 아니라 AI 거래를 유포리아에서 성숙한 검증 국면으로 이동시키는 계기였고, 앞으로 AI 투자는 서사보다 펀더멘털·개별 기업 특이성·실제 실행력이 성과를 좌우하는 ‘스톡 피킹 중심의 시장’으로 재편될 가능성이 커졌음.

Past, Present, and Future - Cursor

AI 어플리케이션의 대표주자 커서는 $29.3b 가치로 $2.3b 레이즈에 성공 (기존 주요 주주들의 팔로업 + Coatue, NVIDIA, Google 신규 참여.) ARR은 $1b 돌파.

불과 반년반에 ARR 2배, 기업가치는 3배 가량 성장했다. AI는 진짜 가치를 만들어내고 있다.

높은 기업가치를 인정받는 스타트업은 꽤나 많지만, 그 안에서 정말 위대한 기업이 될만한 회사들은 소수에 속한다고 생각한다.

그리고 그런 회사들은 분명 보통의 회사들과는 다른 모습을 지니곤 하는데, 마치 커서의 아래와 같은 모습이 대표적이다.

“대부분의 회사에서 채용 과정은 이렇습니다: 특정 기능을 수행할 능력의 공백을 확인하고, 공고를 내고, 지원자 리스트를 확보하고, 면접을 보고, 한 명을 채용하여 몇 달 뒤에 입사시킵니다.”

“커서의 채용 과정은 이렇습니다: 슬랙의 #hiring-ideas 채널에 정말 뛰어난 사람의 이름을 올리고, 관심을 집중시키고, 팀 인터뷰(형식은 매우 다양함)를 진행한 뒤, 서로 원한다면 월요일부터 바로 출근합니다.”

“커서에는 50명(!)의 전직 창업자가 있으며, 이는 회사 전체의 20% 이상입니다. 거의 40%가 MIT, 하버드, 스탠퍼드 등 명문대 출신이지만, 아무도 학벌 이야기를 하지 않습니다. 누군가에게는 커서가 첫 직장이지만, 다른 이들은 피그마, 스트라이프, 우버 같은 곳에서 경력을 쌓았습니다. 진정한 멜팅 팟입니다.”

“커서에서는 사람들이 서로의 작업물을 찌르고 자극합니다. 이런 문화에 익숙하지 않은 사람에게는 꽤 충격적일 수 있습니다. 최고의 빌더들은 훌륭한 제품이 어떤 느낌인지 알기에, 사물이 어떻게 작동해야 하는지에 대해 매우 확고한 의견을 가집니다.”

“커서는 이상적인 고객 프로필이 ‘최고의 전문 소프트웨어 개발자’라고 단호하게 말합니다. 커서는 다른 사용자를 무시하는 것이 아닙니다. 하지만 회사의 입장은, 다른 회사들이 바닥을 낮추는(진입 장벽을 낮추는) 데 집중할 때, 커서는 천장을 높이는(전문가의 능력을 극대화하는) 데 집중하겠다는 것입니다.”

Building an AI Physicist: ChatGPT Co-Creator’s Next Venture

OpenAI와 Deepmind 출신들이 나와서 창업한 Periodic Labs는 현존하는 초전도체보다 더 높은 온도에서 작동하는 초전도체를 개발하는 것을 첫번째 목표로 삼고, 장기적으로는 과학적 발견을 자동화하여 AI 과학자를 양성하는 것을 목표로 하는 스타트업이다. 최근 시드로 $300m 거액을 투자받기도 했다.

처음에는 너무 거창한거 아니야? 싶었는데, 그들의 인터뷰를 살펴보니 꽤나 합리적인 접근인 것 같다는 생각이 들고 (특히 처음부터 모든 것을 바꾸려 하지 않고, 명확하게 범위가 지정되고 검증 가능한 핵심 문제를 해결하는 데 집중한다는 접근법이 마음에 든다), 약간 내가 좋아하는 아이소모픽랩스의 느낌도 나서 앞으로 관찰 대상에 포함시킬 생각이다.

#반도체

AI 추론을 위한 Domain-Specific Architectures

AI 추론에서 왜 메모리가 각광받는지 제대로 알 수 있는 자료. 번역해주신 신종훈님 감사합니다 🙏

정리하면 AI 추론의 근본적인 병목은 ‘연산력(TFLOPs)’이 아니라 ‘메모리 접근 및 데이터 이동’이다. 따라서 성능 향상의 방향은 더 많은 연산 유닛을 추가하는 것이 아니라, 데이터 이동을 최소화하고 메모리 계층 구조·인터커넥트·통신 오프로딩을 최적화하는 것이다. 즉, 효율적인 메모리 설계와 스케일 아웃을 전제로 한 아키텍처가 핵심 경쟁력이 된다.

Ironwood TPUs and new Axion-based VMs for your AI workloads | Google Cloud Blog

Google TPUv7: The 900lb Gorilla In the Room - Semianalysis

구글이 7세대 TPU를 발표.

이제는 가속기 자체의 성능보다 스케일업 네트워킹이 압도적으로 중요해진 상황. 즉, 심플하게 ‘랙 스케일 컴퓨팅’을 어떻게 잘 구현하냐의 게임이 진행 중이라고 본다.

엔비디아는 이를 NVLink (& switch)로, 구글은 이를 광(OCS) 기반의 3D 토러스 구조로 풀어내고 있다.

Expanding our use of Google Cloud TPUs and Services

앤트로픽이 구글 클라우드 및 TPU 사용을 늘린다고 공식 발표. 26년까지 구글 클라우드 1GW 확보하고, TPU 사용을 백만개까지 늘린다는 계획이다. 구글도 앤트로픽에 $3b 투자해서 지분 10% 이상 들고 있는 주요 주주라는 점에서 다변화는 이미 예고되어 있었을지도 모른다 (참고로 아마존은 $8b 투자해놓음)

지금까지 ‘앤트로픽 = AWS = Trainium’을 기본 시나리오로 설정해왔다면, 이제부터는 Trainium: TPU를 8:3 비율로 가정해놓고 관찰해야겠네.

관련해서 한가지 재밌는 포인트는 OpenAI는 자체적으로 인프라를 늘려가는 모습이라면 앤트로픽은 구글 아마존에게 인프라를 맡기고 있다는 부분인데, 이게 나중에 어떤 결과를 나을지도 흥미로운 관찰 포인트이다. 개인적으로는 현재 OpenAI 행보가 장기적으로 엄청난 해자를 가져오지 않을까 생각 중.

Gavin Baker and David George on Positional Strategy in AI - a16z

게빈 베이커는 원래 아마존 ASIC Trainium을 높게 사는 분이었는데, 이제는 구글 TPU를 굉장히 높게 평가하시는군.

“저는 이것이 엔비디아와 구글 TPU 간의 싸움이라고 생각합니다. 그리고 널리 알려지지 않았다고 생각하는 것 중 하나는, 브로드컴과 AMD가 사실상 함께 시장에 진출하고 있다는 점입니다. 젠슨이 내일 말할 것으로 확신하지만, 엔비디아는 더 이상 단순한 반도체 회사가 아닙니다. 반도체 회사였다가, Cuda라는 소프트웨어 회사가 되었고, 이제는 이 랙 레벨 솔루션을 갖춘 시스템 회사가 되었습니다. 그리고 이제는 스케일업(scale up), 스케일 어크로스(scale across), 스케일 아웃(scale out) 네트워킹으로 그들이 수행하고 있는 아키텍처 수준을 볼 때, 틀림없이 데이터 센터 레벨의 회사입니다.”

“그래서 네트워킹, 패브릭, 소프트웨어, 이 모든 것이 중요합니다. 그리고 브로드컴이 메타 같은 회사들에게 말하는 것은 이겁니다. “이봐요, 우리가 NVLink와 인피니밴드(Infiniband) 또는 이더넷(Ethernet)의 혼합인 엔비디아의 패브릭과 이론적으로 경쟁할 수 있는 패브릭을 만들어 주겠습니다. 이더넷 기반으로 구축할 것이고, 오픈 표준이 될 겁니다. 그리고 구글이 3세대에 걸쳐 작동시킨 TPU의 당신 버전을 만들어 주겠습니다. 그리고 만약 당신의 ASIC이 좋지 않다면, 그냥 AMD를 바로 꽂으면 됩니다.”

“저는 개인적으로 이들 ASIC 대부분이 실패할 것이라고 믿습니다. 특히 시간이 지남에 따라 더욱 그럴 것입니다. 특히 구글이 TPU를 외부에 판매하기 시작한다면, 세간의 이목을 끄는 다수의 ASIC 프로그램이 취소되는 것을 보게 될 것입니다.”

“그리고 그게 정확히 어떻게 작동할지는 아무도 모르죠. 왜냐하면 만약 당신이 앤스로픽이고, 소문에 의하면 수백억 달러 규모의 TPU를 구매하고 싶어 한다면, 구글이 당신의 비밀 소스를 보는 것을 원하지 않을 수도 있지만, 그걸 피할 방법은 있습니다. 그래서 저는 이것이 기본적으로 구글과 그들의 TPU - 현재로서는 브로드컴에 의해 가능해진 - 간의 싸움이라고 생각합니다. 그리고 구글은 원할 때 언제든지 브로드컴으로부터 TPU를 가져올 수 있습니다.”

“물론 그들은 브로드컴이 하고 있는 이더넷 네트워킹을 할 수는 없습니다. 하지만 TPU는 그들이 통제하죠. 그래서 이건 정말로 구글과 TPU 대 엔비디아의 싸움이며, 아마존도 마찬가지입니다. 아나푸르나(Annapurna) 팀, 그들은 매우 재능 있는 팀입니다. 트레이니움 3는 아마도 트레이니움 2보다 훨씬 더 좋은 칩이 될 것입니다. 구글이 TPU를 제대로 만드는 데 3세대가 걸렸습니다. 그리고 AMD는 항상 일종의 2차 공급원(second source)이 될 것이고, 2차 공급원은 필요합니다.”

Revolutionizing Networking for the Era of Agentic AI

Unleashing AI Scale Up UALink and OCP Collaboration

OCP 2025 영상들을 쭈욱 돌려보는 중에 그냥 기록해두고 싶은 내용이 있어서:

엔비디아는 인피닛벤드와 별개로 이더넷 기반의 스케일아웃 솔루션 Spectrum-X Ethernet을 가지고 있는데,

“오늘 말씀드릴 수 있는 건 Spectrum-X 이더넷으로 20만 개 이상의 GPU를 단일 잡으로 운영하고 있다는 사실입니다. 이런 숫자를 달성한 다른 이더넷 기술은 없습니다. 우리는 Meta와 함께 일하게 되어 기쁘고, Meta는 이번 주에 스펙트럼 이더넷 스위치 위에 FBOSS를 올려 Minipack을 구축했다고 발표했습니다. 또 Microsoft는 대규모 인프라에서 Sonic + Spectrum 스위치를 발표했고, OCI도 Stargate에서 Spectrum 스위치 사용을 발표했습니다. 전 세계 최대 규모 AI 슈퍼컴퓨터들입니다.”

이걸 보니 스케일업 솔루션에서도 이더넷 기반의 ESUN과 새로운 표준 프로토콜인 UALink가 병행되며 사용될 수 있겠구나 싶은 생각이 들었다.

“네, 이더넷은 스케일업에 사용될 수 있습니다. 풍부한 역사도 있죠. 하지만 이더넷과의 호환성을 유지하려면, UALink가 처음부터 바닥부터 접근하면서 포기하지 않았던 것들 중 일부를 포기해야 합니다. 이더넷의 가장 큰 도전은 전력과 실리콘 크기라고 봅니다. 만약 그것들을 감당할 수 있다면 나쁜 해법은 아닙니다. 다만 성능에서는 따라가기 어렵습니다. 이 분야에서 성능의 기준을 세운 회사는 엔비디아이고, 그들의 NVLink입니다. NVLink와 경쟁하려면, 이더넷의 역사에 억눌리지 않는 무언가가 필요합니다. 그렇지만 제 생각에 두 기술은 충분히 공존할 수 있습니다. 감사합니다.”

Marvell In Advanced Talks to Buy Celestial AI in Multibillion Deal - The Information

마벨도 광 기반 연결 솔루션을 개발하는 Celestial AI 인수 협상을 진행 중이라는 보도. 이 회사의 직전 가치는 $2.5b이고, 현재 최대 $5b 규모로 딜 진행 중인듯.

차세대 전장이 네트워킹이 되어가는 흐름 속에서, 과연 이번 인수가 마벨에게 도약의 기회를 만들어줄 수 있을까. 물론 브로드컴 등 경쟁사들은 이미 준비를 끝낸 것 같지만.

→ 이후 총 $5.5b 규모로 딜 성사. 선지급은 $3.25b로 현금 $1b, $2.25b 마벨 주식으로 지급, 나머지 금액은 29년까지 성과에 따라 지급.

Tesla Third Quarter 2025 Production, Deliveries & Deployments

이번 테슬라 실적발표 내용에서 개인적으로 눈길이 갔던건 자체 칩인 AI5에 대한 설명이었는데, 왜 빅테크들이 ASIC을 필요로 하는지 명확하게 보여주는 것 같았다.

Q. “테일러(Taylor)에서의 165억 달러 규모의 삼성 칩 거래에 대해 업데이트해 주실 수 있습니까? 자율주행과 Tesla의 AI 기반 미래에 반도체가 중요하다는 점을 감안할 때, 삼성이 Tesla의 일정에 맞춰 AI6를 이행하고 TSMC 대비 상대적으로 더 나은 수율과 비용을 달성할 수 있다고 자신하는 이유는 무엇입니까?”

우선, 삼성에 대해서는 칭찬할 것밖에 없습니다. 그들은 놀라운 회사입니다. 그리고 삼성은 우리의 AI4 컴퓨터를 제조하고 있으며 훌륭하게 해내고 있다는 점을 주목할 가치가 있습니다.

이제 AI5에 대해, 그리고 제가 이전에 공개적으로 했던 발언과 관련하여 한 가지 명확히 할 점이 있습니다. 우리는 사실 TSMC와 삼성 모두 초기에 AI5에 집중하도록 할 것입니다. Tesla가 설계한 AI5 칩은 정말 놀라운 디자인이라고 생각합니다.

저는 지난 몇 달간 거의 주말마다 칩 디자인팀과 함께 AI5 작업을 했습니다. 제가 칭찬에 인색한 편이지만, Tesla 칩 팀이 정말 놀라운 칩을 디자인하고 있다고 말해야겠습니다. 몇 가지 지표로 볼 때, AI5 칩은 AI4 칩보다 40%가 아니라, 40배(40x) 더 나을 것입니다. 왜냐하면 우리는 전체 소프트웨어 및 하드웨어 스택(stack)에 대한 상세한 이해를 가지고 있기 때문입니다. 우리는 소프트웨어의 모든 문제점(pain points)을 해결하기 위해 하드웨어를 설계하고 있습니다.

저는 현실 세계에서 자동차와 로봇을 가지고 현실 세계에 맞춰 조정하는 등, 이 전체 스택을 수행하는 곳은 아무도 없다고 생각합니다. 우리는 칩이 무엇을 해야 하는지 알고 있고, 마찬가지로 중요하게도 칩이 무엇을 할 필요가 없는지 알고 있습니다.

몇 가지 예를 들자면, AI5에서는 기존 GPU 또는 전통적인 GPU를 삭제했습니다. 그것은 AI4에는 있지만, AI5에는 없습니다. AI5 자체가 기본적으로 GPU이기 때문에 기존 GPU를 그냥 삭제했습니다. 이미지 신호 처리기(ISP)도 삭제했습니다. 그리고 실제로는 매우 중요한 삭제 목록이 깁니다.

이러한 삭제의 결과로, 우리는 메모리에서 Tesla Trip 가속기, ARM CPU 코어 및 PCI-X 블록으로 가는 트레이스(traces)를 위한 충분한 마진을 두고 AI5를 하프 리티클(half reticle, 반도체 노광 공정 마스크의 절반 크기)에 맞출 수 있습니다. 이것은 아름다운 칩입니다. 저는 이 칩에 개인적으로 엄청난 삶의 에너지를 쏟아부었습니다. 그리고 저는 이것이 차세대 승자가 될 것이라고 확신합니다.

따라서 삼성과 TSMC 모두 AI5에 집중하게 하는 것이 타당합니다. 기술적으로 삼성 팹(fab)은 TSMC 팹보다 약간 더 진보된 장비를 갖추고 있습니다. 이 두 칩은 모두 미국에서 만들어질 것이며, TSMC는 애리조나에서, 삼성은 텍사스에서 생산됩니다.

하지만 우리는 AI5 칩을 과잉 공급하는 것을 명시적인 목표로 삼고 있습니다. 만약 자동차와 로봇에 필요한 것보다 AI5 칩이 너무 많다면, 언제든 데이터 센터에 넣을 수 있기 때문입니다. 우리는 이미 데이터 센터에서 AI4를 학습에 사용하고 있습니다. 우리는 AI4와 NVIDIA 하드웨어를 조합하여 사용합니다. 분명히 말하지만, NVIDIA를 대체하려는 것은 아니지만, AI4와 NVIDIA 하드웨어를 조합하여 사용하고 있습니다. 그리고 AI5의 초과 생산분은 언제든 우리 데이터 센터에 넣을 수 있습니다.

NVIDIA는 계속 발전하고 있습니다. 그들이 가진 과제는 수많은 고객의 광범위한 요구 사항을 충족해야 한다는 것입니다. 하지만 Tesla는 오직 한 고객, 즉 Tesla의 요구 사항만 충족하면 됩니다. 이는 설계 작업을 근본적으로 더 쉽게 만들고, 칩에서 많은 복잡성을 제거할 수 있다는 것을 의미합니다. 이게 얼마나 중요한지 아무리 강조해도 지나치지 않습니다.

칩의 다양한 로직 블록을 볼 때, 로직 블록의 수가 증가하면 로직 블록 간의 상호 연결도 증가합니다. 칩의 여러 부분을 연결하는 데 얼마나 많은 고속도로가 필요한지와 같다고 생각할 수 있습니다. 특히 칩의 각 로직 블록 간에 얼마나 많은 데이터가 오갈지 확신할 수 없다면, 결국 사방으로 거대한 고속도로를 깔게 됩니다. 그것은 거의 불가능에 가까운 어려운 설계 문제가 됩니다. 그리고 NVIDIA는 거의 불가능에 가까운 어려운 요구 사항들을 처리하는 데 놀라운 일을 해냈습니다.

하지만 우리의 경우, 우리는 급진적인 단순함(radical simplicity)을 추구합니다. 그 최종 결과로, 저는 AI5가 와트당 성능에서 최고, 아마도 2~3배, 그리고 AI용 달러당 성능에서 최고, 아마도 10배가 될 것이라고 생각합니다. 뭐, 결과는 두고 봐야 알겠죠. 분명히 우리는 칩을 실제로 만들고 대량 생산해야 합니다. 하지만 그렇게 보입니다.

#인프라

메모리에 이어서, 데이터센터 현황도 한번 가볍게 정리해보았다.

“결국 AI는 컴퓨팅의 확장, 더 정확히는 토큰의 확대, 이로 인한 지능의 대중화 혁명인 것 같다.”

Nvidia’s Jensen Huang on AI & the Next Frontier of Growth

젠슨 황이 말하는 AI와 인프라 게임.

“우리는 우리가 풀고 싶어하는 대부분의 문제들이 딥 러닝 요소를 가질 수 있다는 결론에 도달했습니다. 그래서 우리는 결정했습니다. 아시다시피, 딥 러닝이 지금부터 10년 후, 20년 후에 어디에 있을 수 있을지 어떻게 추론할 것인가? 우리는 연산 문제를 세분화했고, 모든 단일 칩, 모든 단일 시스템, 모든 소프트웨어, 컴퓨팅 스택의 모든 단일 계층이 재창조될 수 있다는 결론에 도달했습니다. 그리고 그것을 추진하기로 한 그 결정은 아마도, 아시다시피, 역사상 더 나은 결정 중 하나였을 것입니다.”

“우리는 칩 하나를 설계하는 것이 아니라, 전체 인프라 전체를 한꺼번에 설계하고 있습니다. 우리는 오늘날 세계에서 유일하게 당신이 건물과, 전력과, 그리고 백지 한 장을 주면, 그 안의 모든 것을 만들어낼 수 있는 회사입니다. 모든 네트워킹, 모든 스위치, 모든 CPU, 모든 GPU, 아시다시피, 그 전체 팩토리 내의 모든 기술을 우리가 구축할 수 있습니다. 그리고 그것은 모두 NVIDIA의 동일한 소프트웨어 스택에서 실행됩니다. 그리고 우리가 그렇게 통합할 수 있기 때문에, 우리는 또한 극도로 빠르게 움직일 수 있습니다.”

“그래서 만약 우리의 와트당, 사용된 에너지 단위당 에너지 성능이 3배라면, 당신의 회사는 그 팩토리에서 3배 더 많은 수익을 창출할 수 있습니다. 그것이 제가 그것을 팩토리라고 부르는 이유입니다. 그것은 데이터 센터가 아니라 팩토리(공장)입니다. 그들은 그것으로 돈을 벌고 있습니다. 그리고, 그리고, 그래서 이 AI 팩토리들은 계속해서 규모를 키우고 싶어 합니다. 그들은 계속해서 수익을 올리고 싶어 합니다. 그들은 계속해서 처리량(throughput)을 높이고 싶어 합니다. 그것이 바로 우리가 그렇게 빠르게 혁신하는 이유이며, 우리를. 따라잡기는 어렵습니다.”

“오늘날 관찰해야 할 것은 AI가 단지 OpenAI나 Anthropic 같은 새로운 회사들에만 관한 것이 아니라는 점입니다. AI는 하이퍼스케일러들이 일하는 방식을 변화시키고 있습니다. 예를 들어, 검색은 이제 AI에 의해 구동됩니다. 추천 시스템, 즉 당신이 광고와 뉴스와 이야기를 보는 방식은 이제 영화가 AI 추천에 의해 생성됩니다. 그러니까 기본적으로 구글의 비즈니스, 아마존의 비즈니스, 메타의 비즈니스, 수천억 달러의 수익이 모두 AI에 의해 구동되고 있습니다. 이제, OpenAI와 앤스로픽이 없다고 하더라도, 이 전체 하이퍼스케일 산업은 AI에 의해 구동되고 있습니다. 그래서 가장 먼저 관찰해야 할 것은 머신러닝을 사용하는 고전적인 CPU에서 이제 딥러닝과 AI로 넘어가야 한다는 것입니다. 그리고 이 전환만으로도 수천억 달러 규모입니다.”

“여러분들은 AI 네이티브 회사들을 보고 계시죠. 그들은 AI 모델에 연결될 것이며, 역사상 처음으로 이전에는 결코 접근할 수 없었던 산업, 즉 노동 산업에 진출할 것입니다. 그리고 그것은 ‘디지털 노동(digital labor)’, ‘디지털 인지(digital cogn)’, ‘에이전틱 AI(agentic AI)’라고 불리며, 기업 시장을 보완하고 증강할 것입니다.”

“AI에 대해 또한 독특한 점은, 이전의 소프트웨어와 달리, AI는 ‘생각’해야 한다는 것입니다. 즉, 당신은 그것을 미리 컴파일(pre-compile)해서 바이너리(binary)로 만들어 다운로드해서 사용할 수 없습니다. 그것은 항상 처리(process)해야 합니다. 왜냐면 그것이 당신의 ‘맥락(context)’을 파악해야 하기 때문입니다.”

“오늘날의 컴퓨터는 ‘상호작용’하고 있습니다. 지금 여기에서 일어나고 있는 맥락에 기반하여, 청중에 기반하여, 전 세계에서 일어나고 있는 일에 기반하여 모든 것을 실시간으로 생성하고 있습니다. 그것이 미래의 컴퓨터입니다. 아시다시피, 당신의 미래 컴퓨터는 당신 앞의 CEO이거나, 예술가이거나, 아시다시피, 시인이거나, 스토리텔러입니다. 그리고 당신은 그것과 협력하여 당신 자신만을 위한 독특한 콘텐츠를 만듭니다. 그래서 미래의 컴퓨팅은 100% 생성형입니다. 그래서 AI 팩토리가 필요합니다. 이것이 바로 제가 우리가 이 여정의 시작점에 있다고 100% 확신하는 이유이며, 우리는 단지 수천억 달러의 인프라를 구축했을 뿐입니다. 매년 수조 달러의 인프라가 구축될 가능성이 높은 것에 비하면 말이죠.”

“(월스트리트가 미래의 AI 팩토리에서 과소평가하는 KPI 한 가지는 무엇입니까?) 단위 에너지당 처리량(throughput per unit energy)이 고객의 수익을 좌우합니다. 그것은 단지 더 나은 칩을 선택하는 것에 관한 것이 아니라, 당신의 수익이 어떻게 될지를 결정하는 것에 관한 것입니다.”

Thoughts on the AI buildout - Patel

결국 현 AI 시대의 진짜 병목은 GPU가 아니라, 그것을 뒷받침할 공장·전력·노동·자본의 물리적 인프라라는 주장. 아래는 GPT에게 부탁한 글 정리:

Fab CapEx Overhang → Nvidia의 수익 규모가 TSMC의 수년치 설비투자를 압도할 만큼, AI 칩 수요가 반도체 제조 인프라의 자본투자 속도를 훨씬 앞서가고 있다. → 이는 반도체 생산 능력이 AI 성장 속도를 따라가지 못하는 ‘자본 과잉 불균형(Overhang)’ 현상을 낳고 있다.

Upstream Expansion 필요성 → 데이터센터 산업은 이제 기존 산업 인프라를 재활용할 수 없고, 전력·구리·터빈 등 물리적 공급망 전체의 신규 투자가 필요하다. → 과거 수요 붕괴 경험으로 보수적인 전통 산업들이 확장에 소극적이라, 하이퍼스케일러들이 높은 마진을 보장하며 증설을 유도할 가능성이 크다.

노동력 병목 (Labor Bottleneck) → 대규모 AI 데이터센터 건설에는 수십만 명의 전기·건설 기술자가 필요해, 숙련 노동자 부족이 가장 큰 제약이 될 수 있다. → 단기적으로는 높은 임금 인센티브로 완화할 수 있지만 장기적으로는 인력 양성 체계가 병목이 된다.

AI CapEx 지속 가능성 → 미국의 연간 AI 설비투자(약 4,000억 달러)가 정당화되려면, 데이터센터가 그만큼의 매출을 창출해야 한다. → 오픈AI·앤스로픽의 폭발적 성장세를 감안하면 10년 내 4,000억 달러 규모의 산업 매출도 가능성이 있다.

전력원 선택과 리드타임 → 데이터센터의 가장 큰 제약은 속도이며, 짧은 리드타임을 가진 천연가스 발전이 선호된다. → 원전은 효율이 높지만 건설 기간이 길어 현실적으로 AI 인프라 확장에 적합하지 않다.

Off-grid 데이터센터 부상 → 전력망 연결 지연을 피하기 위해 메타·xAI 등은 자체 발전형(off-grid) 데이터센터를 건설하고 있다. → 이는 AI 산업이 점점 전력 자급형 ‘민간 발전소’ 모델로 진화하고 있음을 보여준다.

데이터센터 설계 혁신 → 현재의 데이터센터 건설은 수작업 수준이지만, 앞으로는 모듈형 프리패브 방식으로 공장처럼 양산될 것이다. → 닷컴 버블이 광케이블을 남겼듯, AI 버블은 ‘산업화된 컴퓨트 제조 능력’을 유산으로 남길 것이다.

중국의 구조적 우위 → 중국은 칩을 제외한 거의 모든 인프라 부품(태양광, 변압기, 배터리 등)을 지배하며, 대규모 물리적 생산 능력에서 미국보다 유리하다. → 장기적으로는 이러한 산업화 역량이 AI 인프라 경쟁에서 중국의 우위를 가져올 수 있다.

두 가지 시나리오 – Explosion vs Winter → AI 폭발 시나리오에서는 2035년까지 AI 자동화가 GDP를 30% 끌어올리며 미국 전력 사용의 2배 수준까지 성장한다. → 반대로 AI 겨울 시나리오에서는 2029년 거품 붕괴 후 완만한 성장세로 안정화된다.

결론: 자본주의의 물리적 귀환 → AI 시대는 다시 전력·철강·노동 같은 ‘물리적 자산’의 제약에 부딪히며, → 진짜 병목은 GPU가 아니라 그것을 둘러싼 인프라·에너지·노동력이다.

All things AI w @altcap @sama & @satyanadella. A Halloween Special. 🎃🔥BG2 w/ Brad Gerstner

Bg2 Podcast에서 진행한 샘 올트먼과 사티아 나델라와의 대담 (출처: Aim High 텔레그램)

Q) 어제 마이크로소프트와 구글 모두 GPU가 더 많았다면 클라우드 비즈니스가 더 빠르게 성장했을 것이라고 말했습니다. 그리고 제가 이 팟캐스트에서 젠슨황에게 향후 5년 내에 컴퓨팅 파워 공급 과잉이 올 가능성이 있느냐고 물었더니 그는 향후 2~3년 안에는 사실상 불가능하다고 답했습니다. 두 분 모두 젠슨의 의견에 동의하실 것 같습니다. 5~7년 뒤는 내다볼 수 없더라도, 적어도 우리가 방금 논의한 이유들 때문에 향후 2~3년 동안은 컴퓨팅 파워가 남아돌 가능성은 거의 없다는 것에 대해서요.

Satya Nadella) 글쎄요, 제 생각에 이 특정한 경우의 수요와 공급 주기는 사실 예측하기가 어렵습니다. 핵심은 장기적인 추세입니다. 장기 추세는 샘이 말한 대로입니다.

왜냐하면 솔직히 말해서 우리가 지금 겪고 있는 가장 큰 문제는 컴퓨팅 공급 과잉이 아니라 ‘전력(power)’ 이고, 전력 가까이에 ‘건설(builds)’ 을 충분히 빨리 완료할 수 있는 능력입니다. 만약 이를 해낼 수 없다면, 실제로는 창고에 칩이 잔뜩 쌓여 있는데도 제가 플러그인을 꽂을 수 없는 상황이 발생할 수 있습니다. 사실 이게 오늘날 저의 문제입니다. 칩 공급 문제가 아니라, 사실상 제가 ‘칩을 꽂을 준비된 공간(warm shells, 데이터센터)’ 이 없다는 것입니다. 그래서 어떤 공급망 제약이 나타날지는 예측하기 어렵습니다. 왜냐하면 수요가... 예측하기 어렵기 때문이죠.

샘과 제가 “오, 맙소사. 컴퓨팅이 덜 부족하네”라고 말하고 싶어서 여기 앉아있는 게 아닙니다. 그건 단지 우리가 수요가 실제로 어떨지 예측하는 데 그다지 능숙하지 못하기 때문일 겁니다.

그리고 이건 전 세계적인 문제입니다.

한 국가의 한 부문에 대해 이야기하는 것과 전 세계 모든 곳에 그것을 보급하는 것은 전혀 다른 이야기입니다. 그래서 제약은 계속 있을 것이고, 우리가 그것을 어떻게 헤쳐나갈지가 가장 중요할 것입니다. 결코 순탄하고 선형적인 길은 아닐 겁니다.

Sam Altman) 공급 과잉은 반드시 올 겁니다. 그게 2~3년 뒤일지 5~6년 뒤일지는 저도 말할 수 없지만, 어느 시점에는 반드시 일어날 겁니다. 아마 그 과정에서 여러 번 그런 시점이 있을 겁니다. 여기에는 인간 심리와 버블에 대한 깊은 무언가가 있습니다. 또한 사티아가 말했듯이, 이것은 매우 복잡한 공급망이고, 이상한 것들이 만들어지기도 하며, 기술 환경이 크게 바뀌기도 합니다. 만약 아주 값싼 형태의 에너지가 곧 대규모로 상용화된다면, 많은 사람들이 기존에 서명했던 계약 때문에 엄청난 타격을 입을 것입니다. 만약 우리가 ‘지능 1단위당 비용’을 지금처럼 믿을 수 없을 정도로 가령 연평균 40배씩 계속 낮출 수 있다면, 인프라 구축 관점에서는 매우 무서운 속도입니다. 다시 말하지만, 우리는 그것이 저렴해질수록 수요가 훨씬 더 많아질 것이라는 데 베팅하고 있습니다.

하지만 저는 한편으로 이런 두려움도 있습니다. ‘세상에, 우리가 계속 이런 breakthroughs를 만들어내서 모든 사람이 자기 노트북으로 개인 AGI를 실행할 수 있게 되면 어쩌지? 그렇다면 우리가 지금 한 짓.. 막대한 인프라 투자같은 건 완전히 미친 짓이었던 거네?..’ 과거 다른 모든 기술 인프라 사이클의 여러 시점에서 그랬듯이, 어떤 사람들은 정말 크게 타격을 입을 겁니다.

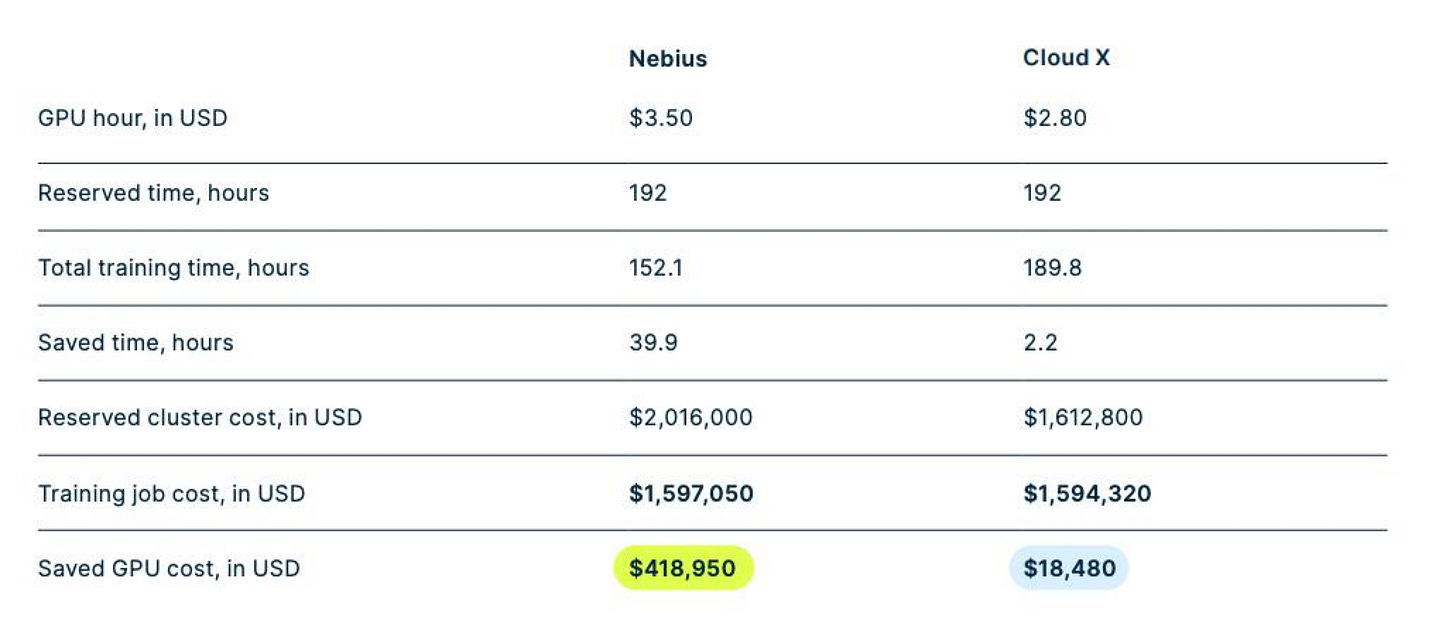

네비우스가 AI 클러스터의 경제성 백서를 공개했다. 뭔가 반도체 공정에서 수율을 잡는게 중요하듯, 확보한 GPU를 최대한 & 효율적으로 돌리는게 핵심이라는 생각이 든다.

지금은 산업 초기라서 일단 계약 용량 확보하는게 시장의 가장 큰 관심사지만, 시간이 지날수록 얼마나 ROI를 뽑아내느냐가 경쟁 우위를 만들어낼 것이라고 본다.

#하드웨어

Random Questions about Physical AI (Kor)

피지컬 AI (= 로봇) 관련해서 주요 이슈들이 잘 정리해되어있는 자료.

“왜 자동차의 크기가 지금과 같은 형태로 고착되었을까요? 물론 여러 이유가 있겠지만, 널리 받아들여지는 해석 중 하나는 자동차가 이전에 존재하던 말이 끄는 마차의 도로 폭에 맞추어 설계되었기 때문이라는 것입니다. 이 관점을 휴머노이드 논의로 가져오면, 결국 인간이 일하던 물리적 환경을 가능한 한 그대로 유지한 채 인간의 노동을 대체하기 위해서는, 인간과 동일한 형태를 지닌 로봇, 즉 휴머노이드가 필요하다는 결론에 다다릅니다.”

“효과적인 작업을 위해 인간형 로봇에 가장 필수적인 요소는 무엇일까요? 제 생각에는 인간과 같은 로봇 손입니다. 사람 손과 유사한 로봇 손을 만드는 일은 생각보다 훨씬 어렵습니다. 고자유도 로봇 손이 어려운 이유는 사람 손의 크기를 유지하면서도 유사한 자유도와 동작 범위를 구현해야 하기 때문입니다. 자연스러운 움직임을 위해서는 각 손가락 끝이 3차원 공간에서 독립적으로 움직일 수 있어야 하고, 이를 위해 최소 15자유도가 필요합니다. 여기에 손목의 3자유도까지 더하면 최소 18개의 모터가 요구됩니다. 이 많은 구동부를 사람의 전완부 크기 안에 집적해 안정적으로 제어하는 것은 극도로 복잡한 문제입니다. 더욱이 사람과 같은 수준의 정밀한 촉각을 구현하려면 재료공학과 센서 기술의 근본적인 발전이 필요합니다. 그렇기 때문에 인간의 손을 닮은 로봇 손은 단순한 기계 설계를 넘어, 로보틱스 전 분야가 동시에 도전해야 하는 과제라고 생각합니다.”

“힘과 감각의 실시간 양방향성이 현재 Physical AI의 가장 중요한 missing piece라고 생각합니다.”

#핀테크

스트라이프가 패러다임과의 협업을 통해 개발중인 결제용 자체 블록체인 Tempo가 $5b 가치로 투자 유치에 성공했다는 뉴스. 내가 가장 좋아하는 Greenoaks와 Thrive가 공동으로 리드했다고 하고, 업계 최고인 Sequoia, Ribbit Capital, SV Angel 또한 같이 투자했다고 한다.

안그래도 업계를 이끌어가는 플레이어들이 시작한 프로젝트라서 눈길이 안갈 수가 없었는데, 투자사 또한 내가 가장 좋아하는 투자사들이 붙었기 떄문에 앞으로 나의 매우 주요한 관찰 대상이 될 것 같다.

#금융

Benchmark’s AI Pressure Test: High Prices, Smaller Stakes—and a Poached Star - The Information

VC의 명가 벤치마크 캐피탈은 전통적으로 투자할 때 지분 20%와 이사회석을 가져오는걸로 유명한데, AI 시대에 이걸로 딜을 따오기가 어려워지니 (+AI가 상대적으로 자본집약 성격을 가지고 있으니) 적은 지분율과 높은 밸류에이션도 어느정도 용인하는 쪽으로 바뀌어가고 있다는 보도.

또한 엄청난 성과에도 불구하고 펀드 사이즈를 늘리지 않는 것 또한 유명한데, 이것도 내부적으로는 펀드 사이즈를 키워야하는게 아니냐는 말이 나왔었다고.

뭔가 최근에 구성원들의 변화가 많았던 벤치마크인데 (Miles Grimshaw(Thrive 이직), Sarah Tavel(벤처 파트너로 전환), Victor Lazarte(독립)), 이러한 이슈들이 영향을 끼치지 않았을까 싶다.

결국 변화를 어느정도 받아들인 것이 나중에 어떤 결과를 가져올지 매우 궁금해진다. AI가 참 많은걸 바꾸어놓는구나.

Benchmark’s GP, Everett Randle on Why Mega Funds Will Not Produce Good Returns

비스타 에쿼티 파트너스, 클라이너퍼킨스, 파운더스펀드, 본드 캐피탈을 거쳐 최근에 벤치마크의 파트너로 조인한 Everett Randle.

그가 말하는 상사들에게 배운점들:

“모두가 메리 미커가 만드는 DCF 모델과 그녀가 다루는 모든 숫자에 대해 이야기하지만, 그녀는 사실 제가 함께 일해 본 투자자 중 가장 질적 투자자입니다. 이 말을 들으면 놀랄 수도 있지만, 그녀가 하는 일은, 그녀는 거의 매트릭스를 읽는 것과 같습니다. 그녀는 한 회사에 대한 역사적인 모든 순차적인 숫자를 펼쳐 놓고, 앞으로 나아갈 모든 숫자도 펼쳐 놓습니다. 예를들어 도어대시를 볼 때, 그녀는 7년 후 80% 성장이나 그런 것을 보지 않습니다. 그녀는 가구의 20%가 월별로 도어대시에서 주문할꺼란걸 그릴 수 있는 사람입니다.”

“저는 피터틸의 영리함과 천재성의 상당 부분이 실제 그의 투자보다는 회사를 구축하는 방식에 있다고 생각합니다. 그가 파운더스 펀드를 설계한 방식은, 그는 끊임없이 당신의 확신(conviction)을 테스트하는 것처럼, 모든 인센티브 구조와 메커니즘을 만들었습니다. 예를 들어, 파운더스 펀드에는 어떤 투자에 참여하는 사람이나 투자를 주도하는 사람이 회사와 개인적으로 함께 투자할 수 있는 프로그램이 있는데, 마치 엔젤 투자하는 것과 같습니다. 언뜻 보기에는 파운더스 펀드의 투자자로서 가질 수 있는 놀라운 특전처럼 보이지만, 더 깊이 들어가면 그것은 확신 테스트입니다.”

“저는 마문이 누구보다도 제품, 시장, 그리고 사람의 조합에 대한 이 완벽한 취향(taste)을 개발했다고 생각합니다. 그의 엄청난 성공작들, 피그마(Figma), 글린(Glean), 리플링(Ripling)을 생각해 보면, 그것들은 모두 공통적으로 B2B 소프트웨어이지만, 정말 높은 사용자 사랑과 참여를 요구하는 소비자 같은 소프트웨어라는 공통된 흐름을 가지고 있습니다.”

ETHval 프로젝트 1주차 소회 — 이더리움의 가치를 어떻게 평가할까

해시드 김서준 대표님의 글:

“돌이켜보면, 저는 지난 10년간 스스로를 “개발자 출신의 예전 창업자인 투자자”로 정의해왔던 것 같습니다. 코딩은 과거의 일이고, 이제 제 역할은 뛰어난 빌더들을 발굴하고 지원하는 것이라고요. 물론 그 역할에 큰 보람을 느껴왔고, 앞으로도 Hashed의 핵심 미션임에는 변함이 없습니다.”

“하지만 이번 경험을 통해 새로운 가능성을 보았습니다. 투자사를 운영하면서도, 현직에서 활발히 개발하며 커뮤니티와 직접 호흡하는 한 명의 빌더로서 살아갈 수 있다는 것입니다. Gen AI가 그 문을 열어주었고, ETHval은 그 첫걸음이었습니다. 앞으로는 “예전에 개발했던 투자자”가 아니라, “지금도 만들고 있는 투자자”로서 이 생태계와 함께하게 될 것입니다. 그 생각만으로도 무척 기대가 됩니다.”

“어쩌면 이것이 Gen AI 시대에 투자자가 가질 수 있는 새로운 엣지일지도 모릅니다. 시장을 분석하고 팀을 평가하는 것을 넘어, 직접 만들어보며 기술의 가능성과 한계를 체감하는 것입니다. 빌더들과 같은 언어로 대화하고, 같은 고민을 공유하는 것입니다. 그것이 더 깊은 이해와 더 나은 투자 판단으로 이어질 수 있지 않을까요.”

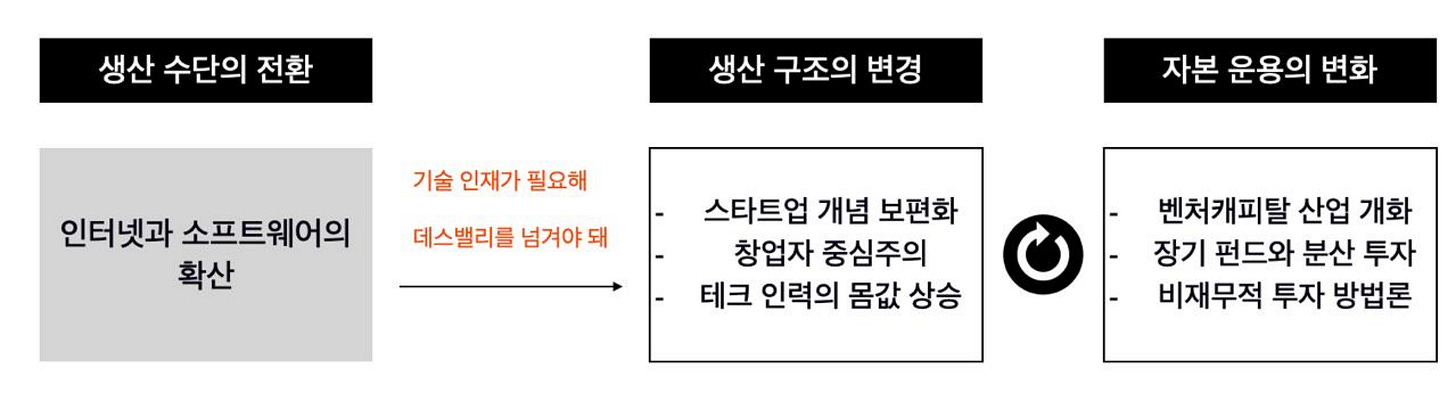

새로운 기술에는 새로운 자본의 형태가 따라붙을 수 있다고 생각한다. 역사가 그걸 증명한다.

만약에 이 형태가 관찰되기 시작하거나 내 머릿속에서 구체화되기 시작한다면, 아마도 나는 여기에 몰입하게 되지 않을까 싶다.

#투자

가상 세계 발전의 병목은 아이러니하게도 실물 자산인건가.

“AI는 인류의 생산성을 재편하는 기술적 경이입니다. 그러나 투자자들이 이 디지털 지능의 창조자들에게 프리미엄을 부여하는 동안, 더 근본적인 변화가 진행되고 있습니다. 세계 경제는 “2D World”(화면, 소프트웨어, 비트의 세계)와 “3D World”(에너지, 인프라, 원자의 세계)라는 두 개의 상이한 생태계 사이에서 극명한 분기점에 다다르고 있습니다.”

“AI는 인플레이션 압력인가, 디플레이션 압력인가?: 여기서 핵심 통찰은 직관에 반합니다. 많은 투자자는 AI가 노동과 지능의 비용을 낮추기 때문에 순수한 디플레이션 요인이라고 봅니다. 2D 경제에 대해서는 맞는 말입니다. 하지만 3D 경제에 대해서 AI는 인플레이션 요인입니다.”

“AI 시대의 아이러니는, 이 기술이 극도로 “물리적(physical)”이라는 점입니다. 클라우드는 강철로 만들어져 있고, 데이터센터는 전자로 구동됩니다. AI 쿼리 하나는 전통적인 검색 쿼리보다 훨씬 더 많은 에너지를 소비합니다. AI 인프라(데이터센터, 전력망 증설, 냉각 시스템)의 구축에는 막대한 양의 구리, 알루미늄, 기저부하 전력이 필요합니다.”

“지금 시장에서 가장 큰 오해는 2D 경제가 3D 경제와 독립적이라는 믿음입니다. 현실에서 2D 세계는 3D 세계에 기생합니다. 디지털 세계는 실물 세계의 에너지와 자원을 탐욕스럽게 소비하려고 합니다. “전통적 컴퓨팅”에서 “AI 컴퓨팅”으로 이동할수록 디지털 세계의 물리적 대가는 기하급수적으로 커지고 있습니다.”

불쾌한 인플레이션의 시대 (IV) - 인플레이션, 그리고 1965년 12월 5일

과연 역사는 반복될 것인가.

“후임자 아서 번즈는 대통령과 매우 가까운 사이였다. 경제학 교수 출신으로 전미경제연구소를 거친 그는 자타공인 경제 전문가였으며, 과거 선거에서 닉슨의 패배가 지나치게 긴축적인 통화정책 때문이었다고 대통령에게 직언한 인물이기도 했다. 그런 그를 금리 인하를 바랐던 닉슨이 연준 의장 자리에 앉힌 것은 어쩌면 너무도 자연스러운 일이었다. 그러나 막상 운전대를 잡은 이 신참 중앙은행장은 자신의 책상에 놓은 여러 경제지표를 보자 지금은 금리인하를 할 상황이 아니라는 것을 깨달았다. 하지만 행정부는 그가 소신대로 움직이게 내버려 둘 생각이 없었다. 그들은 이 샌님 경제학자가 중앙은행의 독립성에 대한 철학을 이러쿵 저러쿵 설교를 늘어놓는 것을 조용히 듣고 있을 생각이 없었다. 재무장관과 백악관의 보좌관들은 아주 집요하고 공격적인 방식으로 아서 번즈에게 압력과 협박을 가했고 결국 연준은 이에 굴해 금리를 크게 내렸다. 그 결과 과열된 경제는 더욱 달아올랐고, 닉슨은 재선에 성공했다. 그러나 그 뒤를 이은 것은 폭발적으로 불어난 통화량과 거센 인플레이션의 파고였다. 그 선택이 어떤 시대를 열어젖혔는지는 오늘의 역사적 평가가 분명히 말해준다.”

“1970년대의 고통스러운 인플레이션이 탄생한 1965년 12월 5일로부터 50년이 흐른 지금, 현재 우리가 마주한 장면들은 반세기 전의 모습들과 데자뷔를 이루고 있다. 우리가 맞이할 불쾌한 인플레이션의 시대는 결국 이렇게 흘러가게 되었다. 아, 이미 헤겔이 말하지 않았던가, 우리는 ‘인간이 역사로부터 아무것도 배우지 못한다는 것’을 역사로부터 배웠다고.”

#비즈니스

Henry Kravis on Building KKR, Deal-Making, and the Future of AI in Private Equity

하나의 자산군을 개척시켰다는 점에서 KKR과 헨리 크라비스는 나에게 언제나 흥미로운 탐구 대상인데, 특히나 헨리 크라비스의 관점과 태도에서 배울께 많다.

“1976년에 회사를 나왔을 때 조지와 저는 32살이었고 돈이 없었습니다. 제리는 우리보다 19살이 많았죠. 사촌 지간인 조지와 저는 각자 1만 달러를 냈고, 제리가 10만 달러를 내서 총 12만 달러로 KKR을 시작했습니다. 그리고 2,500만 달러 규모의 펀드를 조성하러 나갔습니다. 그 시절에는 펀드라는 개념 자체가 없었고, 아무도 우리가 하는 일을 하지 않았기에 자금 조달이 어려웠습니다.”

“우리는 시장의 불일치(discrepancy)를 봤습니다. 당시 이사회는 경영진에게 책임을 묻지 않았고, 기관 투자자들은 주식을 보유만 할 뿐 아무것도 하지 않았습니다. 1970년대와 80년대 초 기업들은 경영 상태가 엉망이었습니다. 우리는 경영진을 단순한 ‘기업 자산의 임차인’이 아니라 ‘주인(Owner)’으로 만들면, 주주와 같은 이해관계를 갖게 되어 행동이 달라질 것이라고 믿었습니다. 경영진과 주주 간의 이해관계 일치(Alignment of Interest), 이것이 핵심이었습니다.”

“중요한 이야기를 하나 더 하자면, KKR의 첫 회의(1976년 5월 1일)에서 두 가지를 논의했습니다. 첫째, 지분 배분. 제리가 40%, 조지와 제가 30%씩. 35초 만에 끝났습니다. 둘째, 문화. 우리는 베어스턴스의 ‘자기가 잡은 것만 먹는(eat-what-you-kill)’ 문화를 싫어했습니다. 내 아이디어를 뺏길까 봐 책상을 잠그고 다녀야 했죠. 우리는 정반대의 회사를 원했습니다. 파트너든 아니든, 딜에 참여했든 아니든, 모두가 모든 일에 참여하고 공유하는 회사요. 49년 반이 지난 지금도 우리는 똑같은 문화를 유지하고 있습니다.”

“저는 호기심이 없으면 훌륭한 투자자가 될 수 없다고 믿습니다. 비즈니스뿐만 아니라 역사, 예술, 문학 등 다방면에 대한 호기심 말입니다. 제 사무실 창밖을 보게 하고 “뭐가 보이나?”라고 물었을 때, 눈에 보이는 것만 말하면 탈락입니다. 전체 풍경을 보고 점들을 연결(connect the dots)해야 합니다. “저기 빈 땅이 있으니 건물을 지을 수 있겠군” 같은 가능성을 봐야죠.”

“그리고 리스크를 감수할 줄 아는 사람을 찾습니다. 요즘 젊은 인재들은 방대한 분석 자료를 가져오지만 정작 방아쇠를 당기는(결정하는) 걸 어려워합니다. 학교에서 모든 질문에 답하도록 배워서 그런 것 같습니다.”

“(실리콘밸리에서는 AI나 기술을 접목한 ‘롤업(Roll-up)’ 전략이 유행하고 있습니다. 이에 대해 어떻게 생각하시나요?) 제가 지금 개인적으로 회사를 하나만 산다면 롤업 전략을 쓸 겁니다. 하지만 AI가 회사를 경영해 주지는 않습니다. AI는 생산성을 높이는 도구일 뿐입니다. 롤업을 하려면 기업 문화를 잘 통합해야 합니다. 문화를 맞추지 않고 회사만 사들이면 충돌이 일어나고 망합니다. 통합(Integration)을 통해 효율성을 높여야지, 덩치만 키우면 안 됩니다. 그리고 예전에는 싼값(PER 6배)에 사서 덩치를 키워 비싸게(PER 15배) 파는 차익거래(Arbitrage)가 가능했지만, 지금은 파는 쪽도 똑똑해져서 싼값에 사기가 어렵습니다. 결국 경영을 잘해야 합니다.”

“(32살의 헨리 크래비스에게 해주고 싶은 조언은?) “보세요, 저는 좋든 나쁘든 항상 리스크를 감수하는 사람(Risk Taker)이었습니다. 사실 KKR을 시작할 때 저는 돈도 없었고 아이가 셋이나 있었습니다. 조지도 마찬가지로 아이가 셋이었고 돈이 없었죠. 우리는 2,500만 달러 펀드를 모으러 나갔지만 합리적인 조건으로 자금을 모을 수가 없었습니다. 여기 계신 여러분은 모두 기업가들입니다. 기업가라면 벽을 뚫고 지나가든 벽을 넘어가든, 어떻게든 반대편으로 가야 합니다. 우리도 그랬습니다. 단지 지금은 그 일을 아주 오랫동안 해온 늙은 기업가일 뿐이죠.”

“당시 우리는 “회사를 운영하는 데 돈이 얼마나 필요하지?”라고 생각했고, 대충 감으로 “50만 달러면 되겠네”라고 정했습니다. 그래서 개인 8명에게 가서 각자 5만 달러씩, 총 40만 달러를 투자받았습니다. 그리고 회사를 인수하면 수수료를 받을 테니 나머지 10만 달러는 그걸로 충당해서 운영비를 쓰자고 했죠. 우리의 목표는 딱 5년만 버틸 수 있게 세팅하는 것이었습니다. 직업도 없고, 돈도 없고, 아이는 셋인 상황에서 “일단 시작해야 해”라고 했죠. 좋은 상황은 아니었습니다.”

“지금 와서 되돌아보며 “무엇을 다르게 했을까?”라고 묻는다면, 딱 하나 다르게 할 것은 “사람에 대한 결단을 더 빨리 내리는 것(Move on people faster)”입니다. 앞서 말씀드렸지만, 그것이 제가 초기에 배웠으면 좋았을 한 가지입니다.”

“(가장 좋았던 조언은?) 조언이라기보다 기회였는데요. 사회 초년생 때 상사가 저를 혼자 로이 디즈니(Roy Disney, 월트 디즈니의 형)에게 보냈습니다. 죽도록 무서웠지만, 모든 자료를 다 공부해서 갔습니다. 15분 미팅이 하루 종일로 이어졌죠. 거기서 얻은 교훈은 **”제대로 준비하면(Do your work), 아주 멀리까지 갈 수 있다”**는 것이었습니다. 그는 제가 매디슨 펀드의 파트너인지, 여름 인턴인지 묻지도 않았습니다. 그가 신경 쓴 건 제가 그의 회사에 관심을 갖고 시간을 들여 공부했다는 점뿐이었습니다.”

“준비를 철저히 하십시오. 요행을 바라고 대충 넘길 수 있다고 생각하지 마십시오. 절대 통하지 않습니다. 준비가 되어 있다면 사람들은 당신에게 주목할 것이고, 나이는 중요하지 않습니다.”

“(KKR은 벤처 캐피털 투자를 하지 않는다고 하셨는데, 헨리 님 개인적으로는 펀드나 스타트업에 매우 활발하게 투자하고 계십니다. 개인 투자에 대한 이야기를 듣고 싶습니다.) 제가 이걸 하는 이유는 호기심 때문입니다. 저는 젊은 기업들이 하는 일, 기업가들이 하는 일을 사랑합니다. 그것이 제 사고를 신선하게 유지해 줍니다. 말씀드렸듯 호기심이 없으면 훌륭한 투자자가 될 수 없다고 생각합니다. 저에게는 배움의 과정입니다.”

“그리고 저는 실수를 해본 사람을 찾습니다. 실수를 안 해봤다면 아무것도 안 한 겁니다. 저는 제가 한 실수, 회사가 한 실수를 줄줄이 읊을 수 있습니다. 그래서 자신의 실수를 인정하는(Fess up) 사람을 원합니다. 기관 투자자를 만날 때도 저는 KKR의 실수부터 이야기합니다. 그러면 그들은 당황하지만, 우리는 인간이기에 실수를 합니다.”

“(호기심의 중요성을 언급하셨는데, 헨리 님은 세상을 배우기 위해 어떤 방법들을 사용하시나요?) 호기심을 유지하고 배우는 방법이라... 1) 저는 독서를 사랑합니다. 역사와 전기(Biographies)를 읽습니다. 2) 전 세계를 끊임없이 여행합니다. 예전엔 1년에 4번씩 아시아에 갔습니다. 사람들을 만나고 문화를 배우는 걸 좋아합니다. 그게 정말 중요합니다. 3) 자선활동: 세 가지 분야에 깊이 관여합니다. 첫째, 의학/과학(특히 암 치료). 아내가 메모리얼 슬론 케터링 암 센터의 연구소장입니다. 둘째, 교육. 소외 계층 학생들을 고등학교부터 대학까지 8년간 지원하는 프로그램을 12년째 맡고 있습니다. 셋째, 예술입니다. 박물관과 갤러리를 자주 갑니다. 뉴욕이든 어디든 시간이 나면 박물관에 갑니다. 그림이나 가구를 보는 것이 제 시야를 열어줍니다.”

“젊었을 때 저는 세상에서 가장 지루한 인간이었습니다. 칵테일파티에 가서도 비즈니스 얘기만 했으니까요. 어느 날 머리를 한 대 맞은 것 같더군요. “너 진짜 지루하다. 누가 네 얘기를 듣고 싶어 하겠어?” 그래서 바꾸기로 했습니다.”

The Mistake That Changed Blackstone Forever: Life Lessons with Stephen A. Schwarzman

스티븐 슈워츠만의 말:

“무언가에 인생을 바치려 한다면, 당신이 무엇을 하고 싶은지에 대한 명확한 시각화를 해야 합니다. 왜냐하면 남들이 하는 것만 그대로 따라 한다면, 결코 독창적인 무언가를 만들어낼 수 없기 때문입니다.”

“우리는 ‘남들과 다른, 유일한 것’을 할 수 있을까에 집중했습니다. 그 당시에는 놀랍게도 M&A 전문 부티크가 존재하지 않았습니다. 그래서 우리는 금융 업계에 없던 새로운 구조를 만들어냈고, 오늘날까지도 그 동일한 전략적 계획을 실행 중입니다. 새로운 개념을 만들어낸 게 아니라, 처음 세운 방향을 흔들림 없이 실행해온 것이죠.”

“저는 항상 이렇게 생각했습니다. 인생에서 사람은 정말 의미 있는 일을 만들기 위한 ‘단 한 번의 초인적인 노력’만이 가능하다고요. 성공에는 수많은 장애물이 있기 때문에, 한 번 승부를 걸 때는 반드시 이겨야 합니다. 이기기 위해서는 엄청난 양의 연습이 필요하고, 스스로를 한계까지 밀어붙여야 합니다.”

“그리고 보통은 무언가 잘못되었을 때 배웁니다. 즉, 존재하는 줄도 몰랐던 구멍을 막지 못했을 때 말이죠. 좌절은 끔찍하지만, 동시에 가장 위대한 스승이기도 합니다. 그래서 처음에는 정말 큰 꿈으로 시작하고, 그것을 달성하기 위해 필요한 세부 단계로 쪼개야 합니다.”

“제가 하는 일이 바로 그겁니다. 수많은 입력들이 제 머리로 들어오고, 저는 그것들을 머릿속에서 조합하고 움직입니다. 그러다 보면 무언가 맞지 않는 정보 조각이 하나 눈에 띄죠. 그리고 또 다른 불일치한 데이터를 발견하면, 그 둘을 맞춰 직선을 만들 수 있습니다. 그리고 그 직선이 어디로 향하고 있는지를 알아내는 것이 제 일입니다.”

“블랙스톤을 창립했을 때 제가 제일 먼저 한 일은, 이상하게 들리겠지만 그래픽 디자인 회사를 고용해 로고와 문서 디자인을 맡긴 일이었습니다. 저는 ‘우리가 세상에 어떻게 보이느냐’가 전부라고 생각했거든요. 브랜드, 이름, 외형 — 모두 메시지를 전달합니다.”

“피 섞어도 보통 섞는 게 아냐” 네이버·두나무 빅딜 속사정 - 중앙일보

역시 결국 마지막은 사람이었다. 그리고 이런 결정을 내린 이해진 의장이 정말 대단해보인다.

“이해진 의장이 사석에서 국내에서 가장 좋아하고 ‘리스펙’(존경)하는 정보통신기술(ICT) 분야 창업자를 얘기할 때가 있었다. 2명을 꼽았다. 송 회장과 장병규 크래프톤 이사회 의장이다. 이유는 생각보다 간단하다. 직접 창업한 회사를, 굉장히 돈을 잘 버는 회사로 키웠다는 점이다.

이것 만은 확실하다. 이 의장이 본인 다음으로 내세울 인물은 관리형이 아니라 창업가형 인물을 염두에 두고 있다는 점이다. 송 회장이 후계자로 낙점됐다고 볼 수는 없지만, 후계자 풀에 들어간 건 맞다고 본다. 사실 지금 이해진 의장은 네이버 지분이 3.73%로, 지배구조가 취약하다. 혼자서 결정할 수 없다는 의미다. 네이버 내부에서도 창업가 수준으로 성과를 낸 인물들이 많이 있다. 이들 사이에서 의미 있는 성과를 내고, 네이버 내·외부의 이해관계자들을 납득시키는 건 송 회장의 몫이 될 거다.”

“스테이블 코인(화폐에 연동해 가격 등락폭을 줄여 가치를 유지하는 암호화폐)시대가 도래하면 결제 수단에 대한 변화가 반드시 생길 것이란 큰 흐름을 이 의장이 읽은 것 같다. 다만 구체적인 사업 내용까지 진도가 많이 나간 건 같지는 않다. 사업보다는 사람 중심으로 이번 딜을 바라보는 게 그림이 더 잘 그려질 거다. 앞으로 사업은 송 회장 등 다음 사람들이 꾸려나가는 것이고, 이 의장은 그 판을 깔아준 것이라 본다.”

“내가 제안” vs “인생 최대 고민”…이해진·송치형이 밝힌 ‘빅딜’ 비하인드 - 한국경제

“같이 일하게 된다면 네이버뿐 아니라 대한민국 전체 소프트웨어 생태계에도 도움이 될 수 있는 사람이라고 생각해서 제가 먼저 제안했습니다.”

“지분이 줄어드는 건 이 의장에게는 고민거리가 아니었다. 이 의장은 네이버를 창업하고 지금까지 네이버를 키우기 위해 투자받았고, 여러 번의 인수합병을 진행했다. 그럴 때마다 창업자인 그의 지분은 줄어들었다. 하지만 그런 선택을 했기에 지금의 네이버로 성장할 수 있었다는 설명이다.”

“이 의장은 “회사를 지분으로 운영한다고 생각하지 않는다”며 “회사에 기여할 수 있다면 계속 역할을 하면 되는 것이고, 그렇지 않다면 더 능력 있는 사람들이 회사를 이끄는 것이 맞는다고 생각한다”고 했다. 그러면서 “지분이 줄어드는 것보다는 이 회사가 더 잘될 수 있느냐, 우리 직원들이 더 재밌는 서비스와 새로운 도전을 할 수 있느냐, 그게 훨씬 중요하다”고 덧붙였다.”

버크셔 해서웨이의 토드 콤스 인터뷰 (2023년 10월) - Bluewater

“주변 사람이 당신 안에서 당신보다 먼저 잠재력을 본다면, 그것만큼 강력한 축복은 없습니다.”

#마지막으로

taste & beauty. 닐 메타가 왜 SSI에 투자했는지 알 것 같기도 하다.

Dwarkesh Patel:

마지막 질문입니다. “연구의 취향(research taste)”이란 뭘까요? 당신은 분명 AI 연구를 하는 데 있어서 세계에서 가장 뛰어난 취향을 가진 사람으로 여겨집니다. AlexNet부터 GPT-3까지, 딥러닝 역사상 가장 큰 사건들에 공동 저자로 참여하셨죠. 그게 대체 무엇이고, 그런 아이디어들을 어떻게 떠올리는지 당신 방식은 어떻게 설명할 수 있을까요?

Ilya Sutskever:

제 개인적인 관점에서 답해볼게요. 사람마다 방식은 다르다고 생각합니다. 저를 개인적으로 이끄는 한 가지는, AI가 ‘어떻게 생겨야 하는가’에 대한 어떤 미학적 기준입니다. 사람은 어떤 존재인지에 대해 생각하되, “올바르게” 생각하려는 거죠. 사람을 잘못 이해한 채로 생각하는 건 정말 쉽습니다. 그렇다면 사람을 올바르게 생각한다는 건 무슨 뜻일까요?

예를 몇 가지 들어볼게요. 인공 뉴런이라는 아이디어는 뇌에서 직접 영감을 받은 것이고, 아주 훌륭한 아이디어입니다. 왜냐하면 이렇게 생각하게 되니까요. 뇌에는 여러 구조가 있고, 주름도 있지만 그 주름은 아마 중요하지 않을 수 있어요. 그런데 우리는 왜 뉴런이 중요하다고 생각할까요? 뉴런은 엄청나게 많기 때문입니다. 뭔가 “그게 맞는 것 같다”는 느낌이 들죠. 그래서 뉴런이라는 단위를 원하게 됩니다. 그리고 뉴런들 사이의 연결을 바꾸는 어떤 국소적(local) 학습 규칙도 원하게 돼요. 뇌가 실제로도 그런 방식으로 작동할 것 같거든요.

분산 표현(distributed representation)이라는 아이디어도 마찬가지입니다. 뇌는 경험에 반응하니, 우리의 신경망도 경험으로부터 학습해야 한다는 생각이죠. 뇌가 경험에서 배우면, 신경망도 경험에서 배워야 한다. 그러다 보면 스스로에게 묻게 됩니다. 어떤 것이 근본적인가, 근본적이지 않은가? 사물은 원래 어떻게 “되어야” 하는가?

이런 것들이 저에게 꽤 큰 길잡이가 되어왔습니다. 여러 각도에서 생각해보고, 거의 ‘아름다움’—아름다움과 단순함—을 찾는 거죠. 추함은 들어설 자리가 없습니다. 아름다움, 단순함, 우아함, 그리고 뇌로부터의 올바른 영감. 이 모든 것들이 동시에 존재해야 합니다. 그것들이 더 많이 충족될수록, 탑다운 믿음을 더 확신할 수 있어요.

이 탑다운 믿음은 실험 결과가 내 예상과 충돌할 때도 나를 버티게 해줍니다. 데이터를 항상 신뢰하기만 하면, 가끔은 내가 방향은 맞게 가고 있는데 단지 버그가 있어서 결과가 틀어질 수도 있거든요. 그런데 그 버그가 있다는 걸 우리는 모릅니다. 그러면 어떻게 버그가 있다는 걸 알아챌 수 있을까요? 계속 디버깅해야 하는지, 아니면 이 방향 자체가 틀렸다고 결론 내려야 하는지 어떻게 판단하나요? 그때 필요한 게 탑다운입니다. “세상은 이렇게 되어야만 해. 이런 방식은 반드시 작동해야 해. 그러니 계속 가야 해.”라고 말해줄 수 있는 것. 그게 탑다운이고, 그 근거는 여러 층위의 아름다움과 뇌로부터의 영감에 있습니다.

참고) 닐 메타 왈:

그린옥스 내부에서 베니랑 하루 종일 같이 있다 보면, 아마 가장 의외라고 느낄 만한 게 ‘아름다움(beauty)’에 집착한다는 점일 거예요. 저희는 재무제표 보는 것도 좋아하지만, 결국 ‘아름다운 비즈니스’를 좋아하고, 아름다운 관계를 맺고, 세상을 조금 더 낫게 만들고 싶어 해요. 그래서 그린옥스도 단순히 매출 3배에 사서 5배에 파는 그런 투자에는 관심이 없고, 진짜로 세상에 기여하는 회사를 찾는 거죠.

지금 제가 하는 일은 훌륭한 창업자를 발굴하고, 그들이 ‘세대를 대표하는 회사’를 세우는 것을 돕는 일인데, 여기에도 분명 예술성이 있다고 생각해요. 저희가 그린옥스 내부에서 회사를 ‘그림을 그리는 화가’에 비유하곤 하는데, 저희 젊은 팀원들에게 “만약 화가를 평가하는 일을 한다면, 어떤 캔버스와 물감을 쓰는지, 혹은 다른 형태의 예술을 사용하는지 깊이 공부해야 해”라고 얘기합니다. 역사상 위대한 화가들을 연구하고, 또 화가들과 직접 이야기하는 거죠. 결국 회사를 만들고 운영한다는 건 일종의 ‘창업자의 작품’이라고 할 수 있고, 저는 그런 작품이 가진 ‘품질(quality)’에 대한 안목을, 그 총포점 경험을 통해 어느 정도 얻었다고 생각합니다.